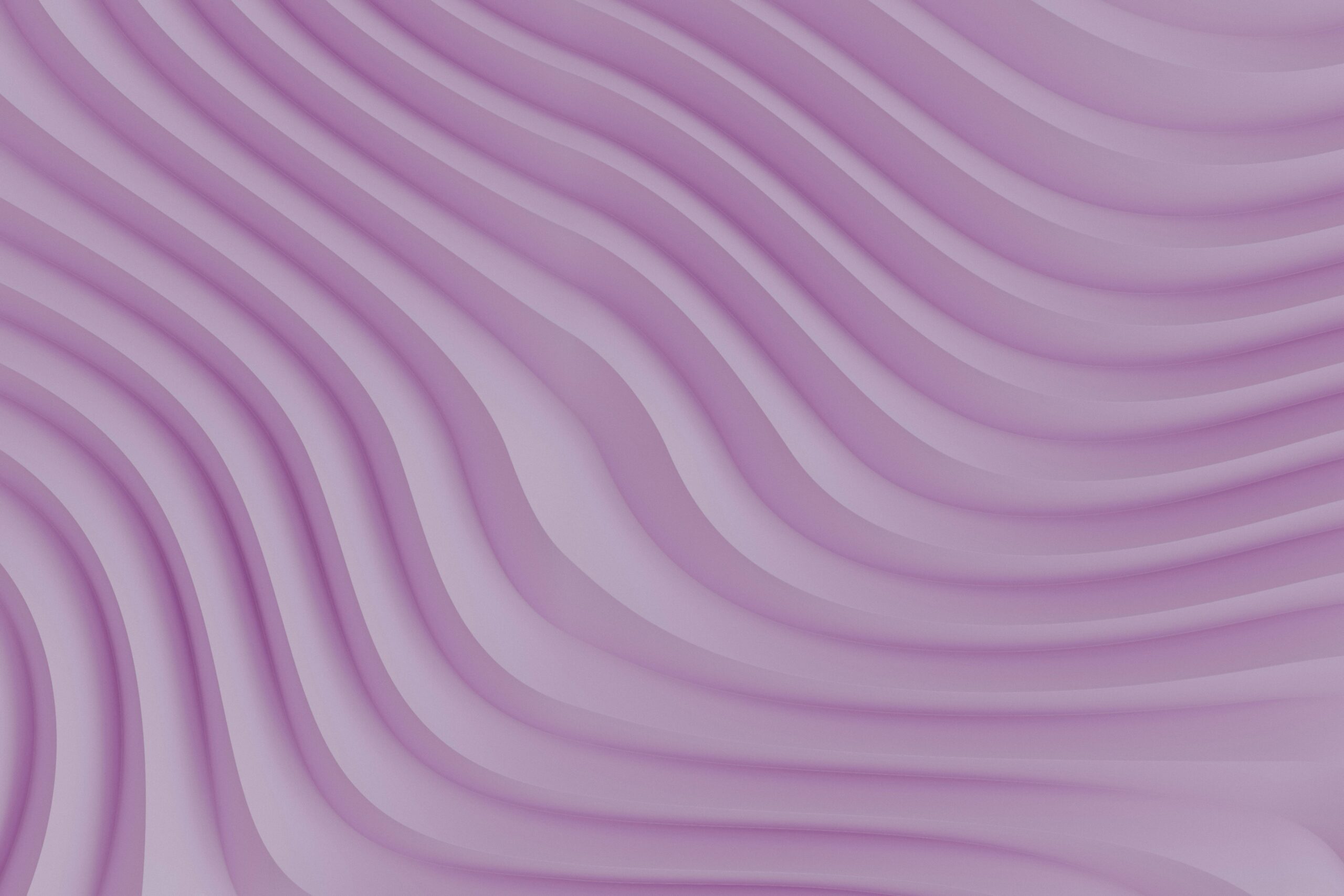

그림 한 장, 텍스트 몇 줄, 혹은 사진 한 장으로 나만의 가상 세계를 만들 수 있다면 어떨까요? 올해 2월 구글이 공개한 구글 Genie (Generative Interactive Environment)는 바로 그런 마법을 가능하게 하는 모델입니다.

이번에는 구글이 후속작 Genie 2를 선보이며 World Model로 나아갈 것을 시사했는데요. AI가 세상을 이해하고 예측하며 행동할 수 있도록 돕는 World Model의 개념과, Genie 2가 어떤 혁신을 가져왔는지 함께 살펴보겠습니다.

World Model

구글 Genie 2는 DeepMind 블로그를 통해 공개됐습니다. 앞서 출시한 Genie 1은 플레이 가능한 게임을 만들어준다는 점을 부각했는데요. 이번에는 Foundation World Model이라는 점을 전면으로 내세웁니다. 그렇다면 World Model은 무엇이고, 환경과 상호작용한다는 것은 어떤 의미를 가질까요?

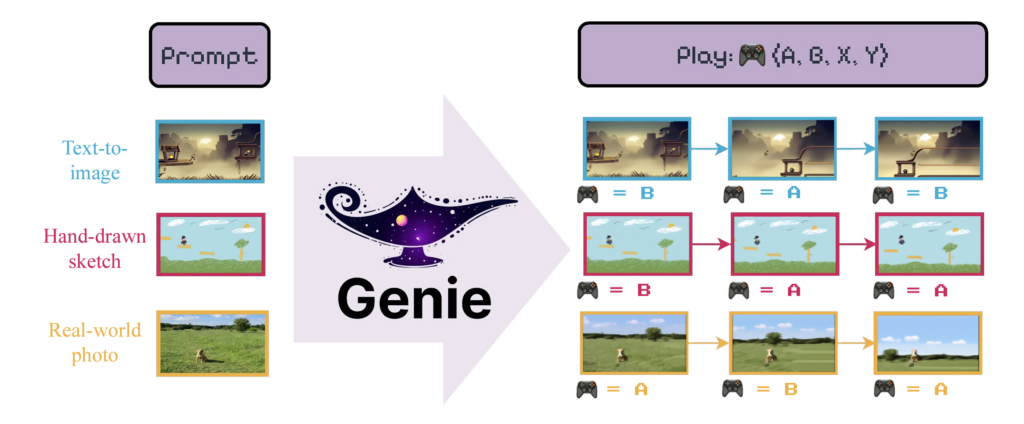

자율 지능을 위한 시스템 아키텍처. 출처: Meta

AI 시스템의 지능 향상을 위해 World Model 개념이 필요하다고 강조해온 Meta AI의 수석 연구자 얀 르쿤에 따르면, World Model은 AI가 세상, 혹은 가상 환경을 이해하고 그 안에서 계획, 예측, 행동할 수 있도록 돕는 핵심 기술입니다. 쉽게 말해, AI가 "세상을 이해하고 움직이기 위한 두뇌" 같은 역할을 하지요. 도로 상황을 이해하고 그에 맞는 주행 계획을 세우는 자율주행차를 예로 들 수 있습니다.

Genie 2는 르쿤이 제안한 World Model 개념을 확장하고 실현한 사례입니다. Genie 2는 AI가 환경을 단순히 학습하는 것을 넘어, 실제로 상호작용 가능한 가상 환경을 생성할 수 있는 능력을 갖췄는데요. 기존 World Model은 보통 행동 라벨(Action Labels)과 같은 구조화된 데이터가 필요했습니다. 하지만 Genie는 인터넷에서 수집한 대규모 비디오 데이터만을 사용하여 학습합니다. AI가 특정 태스크나 도메인에 특화된 데이터 없이도 환경의 동작 원리를 학습하고, 이를 토대로 상호작용할 수 있다는 의미지요.

Genie, 무얼 할 수 있어?

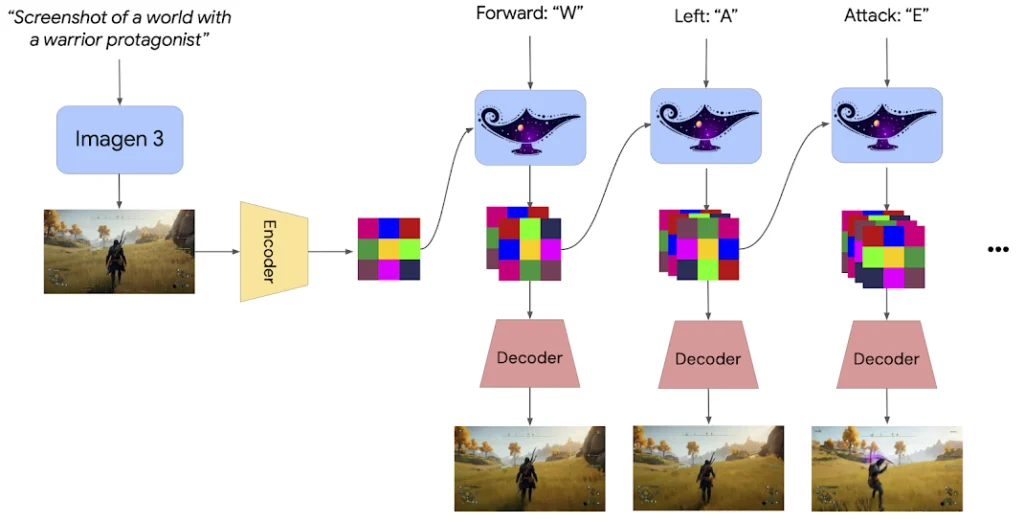

Genie 2는 대규모 비디오 데이터셋을 기반으로 학습된 Autoregressive Latent Diffusion Model입니다. 비디오 프레임을 오토인코더로 처리한 후, 대형 트랜스포머 동적 모델에 전달하여 순차적으로 다음 프레임을 생성하는 방식인데요. 쉽게 말하면, 비디오를 조각조각 나눠서 이해한 다음, 이어질 장면을 상상하며 만들어 냅니다. 또한 행동 제어를 개선하기 위한 노력도 했는데요. 별도의 분류기를 사용하지 않고도 모델이 사용자의 입력을 정확히 이해하고 반응하는 Classifier-free Guidance 기법을 적용했습니다.

Genie 2의 학습 구조. 출처: Google DeepMind

이렇게 학습된 구글 Genie 2는 다양한 요소를 묘사하여 생성할 수 있는 능력을 가지고 있습니다. 먼저, 기본이자 핵심인 행동 제어(Action Control)는 능력은 사용자가 키보드를 통해 특정 키를 눌렀을 때 해당 행동이 가상 환경에서 무엇을 의미하는지 해석할 수 있습니다. 인간은 화살표 키를 눌렀을 때 캐릭터가 이동해야 한다고 인지하고 있지만, 모델은 학습하지 않으면 무엇을 움직여야 하는지 알기 어렵습니다. 하지만 Genie 2는 나무나 구름 등은 이동시키는 요소가 아니라 배경임을 스스로 파악합니다.

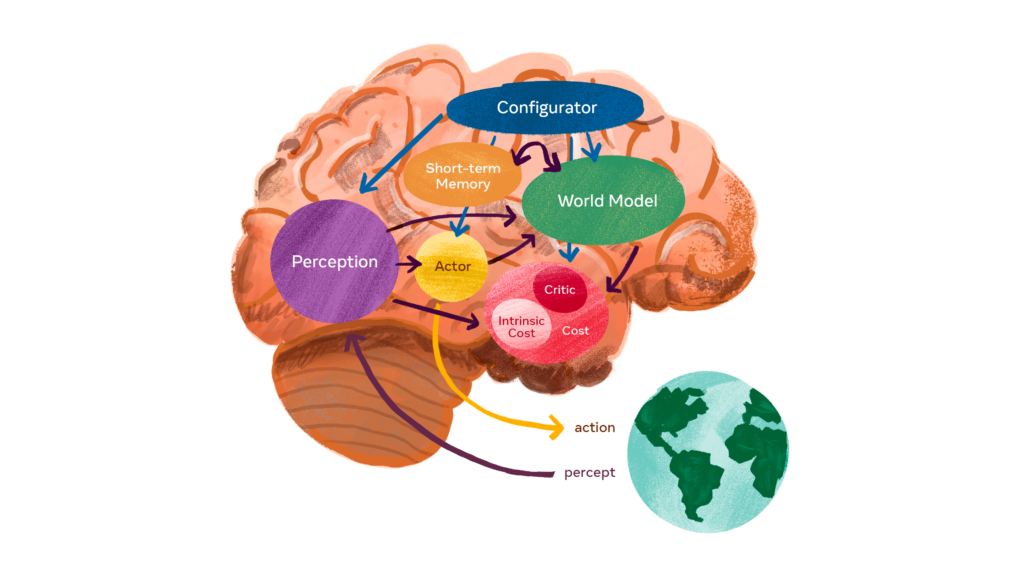

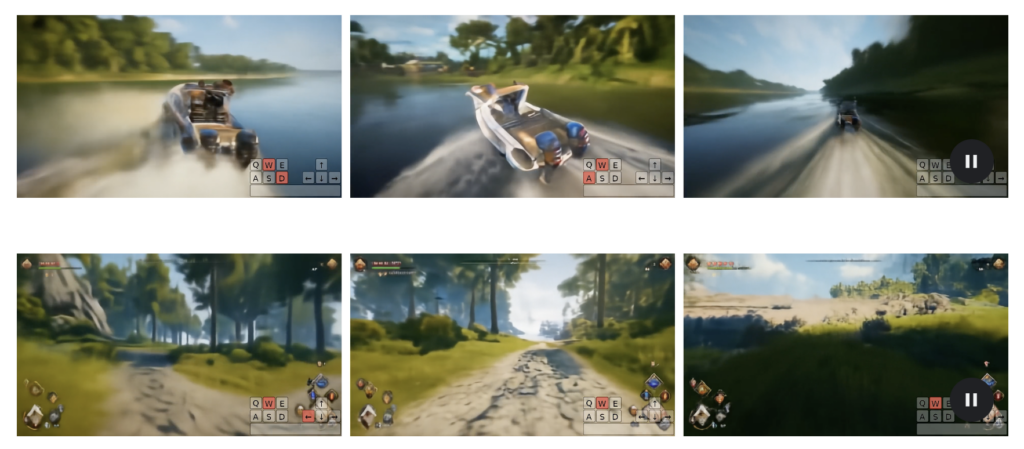

대안적 시나리오(Counterfactual Scenario) 생성 역시 Genie 2의 특별한 능력 중 하나인데요. 동일한 초기 상태에서 시작하지만, 사용자가 선택한 움직임에 따라 완전히 다른 결과가 나타날 수 있습니다. 이는 학습 중인 에이전트가 서로 다른 선택지를 경험할 수 있는 기회를 제공하지요. 또한, AI가 다양한 시나리오를 통해 보다 포괄적인 학습을 할 수 있도록 돕습니다. 강화 학습 및 시뮬레이션 환경에서 특히 유용한 기술이라고 볼 수 있지요.

Genie 2가 생성한 대안적 시나리오(Counterfactual scenario). 출처: Google DeepMind

위 이미지는 실제 게임 영상 같지만, 모두 Genie 2가 생성한 결과물입니다. 동일한 곳에서 출발했지만 어떤 버튼을 입력했느냐에 따라 결과가 달라집니다.

이밖에도 구글 Genie 2는 긴 시간 동안 기억을 유지하여 화면에서 사라진 세계의 요소를 정확히 복원하는 장기 기억(Long Horizon Memory) 능력을 가지고 있습니다. 새로운 콘텐츠를 실시간으로 생성하면서도 최대 1분 동안 일관된 세계를 유지하는 긴 비디오 생성(Long Video Generation) 능력도 있지요. 이 뿐만이 아닙니다. 물리적 효과, 물의 움직임, 연기, 그리고 조명과 같은 시각적 요소를 사실적으로 모델링하여 더욱 몰입감 있는 환경을 만듭니다.

구글 Genie & SIMA

상호작용할 수 있는 환경을 생성했다면, 이제는 상호작용할 주체를 만들어주어야겠지요? 즉, 누군가는 버튼을 입력하고 행동을 제어해야 합니다. Google DeepMind의 연구자들은 올해 3월 개발한 SIMA 에이전트를 Genie 2가 생성한 새로운 3D 환경에 활용하여 그 성능을 평가했습니다. SIMA는 자연어로 주어진 프롬프트를 이해하고 이를 바탕으로 행동하는 에이전트인데요. Genie 2가 제공한 환경에서 키보드와 마우스를 사용해 아바타를 제어하며 사용자가 요청한 사항을 수행합니다. Google DeepMind는 여기에 이미지 생성 모델 Imagen 3까지 더해 완벽한 자동화 체계를 구축했습니다.

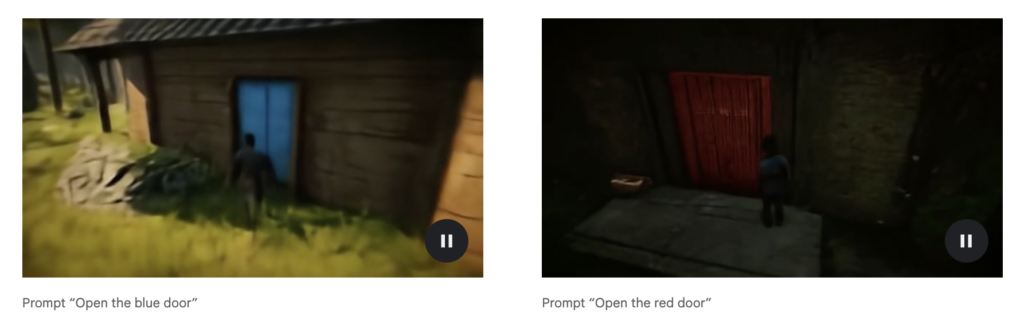

위 이미지는 Imagen 3로 생성한 게임 속 한 장면입니다. 왼쪽에는 빨간문, 오른쪽에는 파란문이 있지요? 사용자의 조작이나 명령에 따라 게임 결과가 달라질텐데요. 이때, SIMA에 프롬프트를 입력하면 SIMA는 캐릭터를 어떻게 움직여야 하는지 조종합니다. Genie는 그에 맞게 장면을 생성하지요.

이러한 기능은 Genie 2가 단순히 에이전트의 훈련 데이터로 활용되는 것을 넘어서게 해줍니다. AI 에이전트의 능력을 평가하기 위한, 미리 경험해보지 못한 환경을 생성할 수 있다는 점이 매우 중요한데요. 연구자들은 Genie 2를 활용하여 새로운 환경을 만들고 에이전트의 일반화 능력과 문제 해결 능력을 시험할 수 있게 되었습니다.

구글 Genie 2는 보다 좋은 환경을 구축했다는 점보다도, 가상의 에이전트 SIMA가 활동할 수 있는 가상의 환경을 구축했다는 점에 의의가 있습니다. SIMA에게 명령만 내리면 게임을 원하는 대로 즐길 수 있다고 볼 수 있지요.

World Model의 기본 전제는 AI가 학습 가능한 환경 속에서 스스로 행동을 결정하고 적응하는 것입니다. 이를 통해, AI는 다양한 상황에서 학습하며 효과적인 의사결정 방법을 터득하게 되지요. AI가 단순히 시뮬레이션을 넘어 현실 세계의 환경을 이해하고 학습한다면, 조만간 인간처럼 자연스럽게 상호작용하는 단계에 이를지도 모르겠습니다.

References