추론 능력 향상

딥시크 -V3-0324 업데이트의 핵심은 바로 Reasoning Capabilities, 즉 추론 능력 강화입니다.

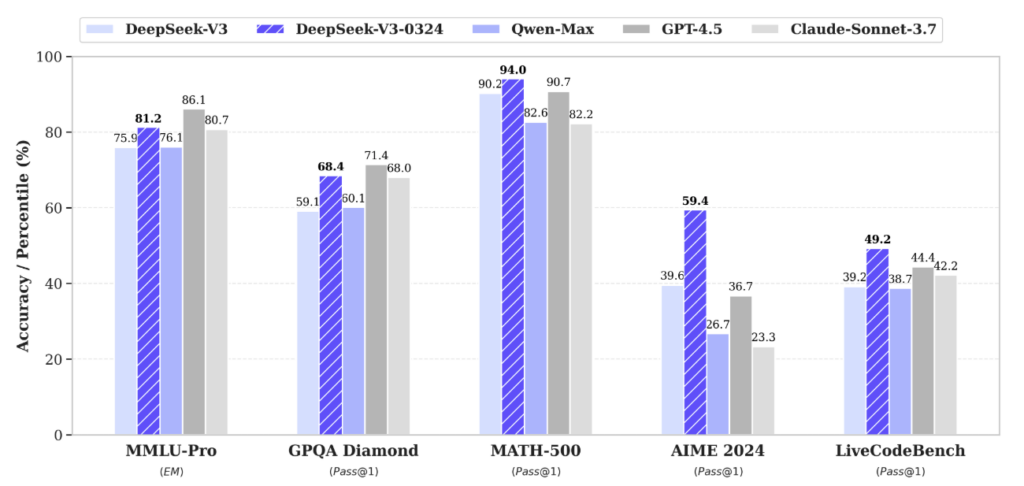

이번 버전에서는 단순한 정보 회상을 넘어, 복잡한 문제를 분석하고 논리적으로 해결하는 능력이 얼마나 향상되었는지를 다양한 벤치마크 수치를 통해 확인할 수 있습니다.

최신 딥시크 모델과 다른 모델 비교. 출처: DeepSeek

기존 벤치마크들이 대부분의 모델에게 너무 쉬워졌다는 이른바 "벤치마크 포화(Benchmark Saturation)" 문제가 제기되고 있지만, DeepSeek V3는 여전히 도전적인 평가셋들에서 실질적인 성능 향상을 보이며 경쟁력을 입증합니다.

특히 AIME, GPQA, MATH-500과 같은 고난도 추론 중심의 벤치마크에서 눈에 띄는 개선이 있었습니다.

이는 단순 점수 이상의 의미를 가집니다. 모델이 실제로 "사고"하고 문제를 해결할 수 있는 능력을 갖춰가고 있다는 뜻으로 해석할 수 있기 때문이지요.

각 벤치마크는 어떤 의미를 가질까?

MMLU-Pro

전문가 수준의 지식과 개념을 바탕으로 한 고차 추론 능력 평가

- 전통적인 MMLU 벤치마크(57개 분야, 12,000개 문제)를 기반으로 한 고급 버전

- Pro 버전은 더 높은 난이도의 전문 문제를 포함해, 전문가 수준의 언어이해 능력을 평가

평가 영역

- 다양한 학문 분야: 의학, 법학, 역사, 수학, 철학, 컴퓨터과학 등

- 주로 4지선다형 문제

- 고난이도 지식 기반 추론을 요구

평가 목표

- 단순 암기 능력이 아니라, 심화된 개념 이해, 상황 판단, 추론 능력을 테스트

GPQA

대학원 수준의 과학 개념을 기반으로 한 복합적 추론 및 논리적 판단 능력 평가

- 이름 그대로 "Google-Proof"—즉, 단순 검색으로는 풀 수 없게 만든 벤치마크

평가 영역

- 물리학, 생물학, 화학, 천문학 등 과학 전공 문제

- 문제들이 복합적 추론, 개념 연결, 지식의 응용을 요구

평가 목표

- LLM이 고등 과학 지식을 이해하고 논리적으로 조합해 문제를 해결할 수 있는지 평가

MATH-500

GPT-4조차 어려워하는 고난도 수학 문제들로 구성. 진정한 수학 추론 역량의 시험대

- MATH benchmark(고급 수학 문제 모음)에서 특히 어려운 500문제만 추출한 서브셋

- 정교한 수학 추론 능력을 집중적으로 테스트

평가 영역

- 대수학, 정수론, 수열, 기하학, 조합 등

- 문제 구조는 수학 풀이 과정 기반의 주관식

목표

- 수학 문제에 대해 풀이 계획을 수립하고, 단계별로 논리 전개할 수 있는지 확인

- 수식 사용, 다단계 추론, 수학적 사고 능력 평가

AIME

고급 수학 문제 해결력 테스트. 특히 정확한 수학적 사고와 계산 기반 추론 능력 요구

- 미국 수학 경시대회 시리즈 중 하나

- AMC에서 고득점을 받은 학생들이 치르는 심화 수학 대회

- 16문제, 각 문제는 정답이 0~999의 정수

평가 영역

- 고등수학: 대수, 기하, 조합, 수열, 정수론 등

- 주로 논리적 사고, 정교한 수학적 추론 필요

평가 목표

- 단순 계산 능력이 아닌, 복잡한 수학 문제 해결 전략 수립과 실행 능력 평가

LiveCodeBench

문제 이해 → 알고리즘 설계 → 동작하는 코드 작성까지의 실전 프로그래밍 능력 평가

- LLM의 실제 프로그래밍 능력을 평가하는 벤치마크

- 단순한 코드 생성이 아니라, 테스트 케이스를 통과하는 동작 코드를 짤 수 있는지를 평가

평가 영역

- 알고리즘

- 문자열 처리

- 자료구조

- 수학 문제

- 실제 문제 해결을 위한 코드 작성

평가 목표

- 문법적 코드 생성이 아닌, 정확히 동작하고 문제를 푸는 실전 코드 능력 평가

또 다른 개선점

이번 V3 업데이트는 단순히 지능 벤치마크만 잘 푸는 모델이 아닙니다. 실제로 사용할 수 있는 실용 기능들에서도 뚜렷한 개선이 있었습니다. 가볍게 살펴볼까요?

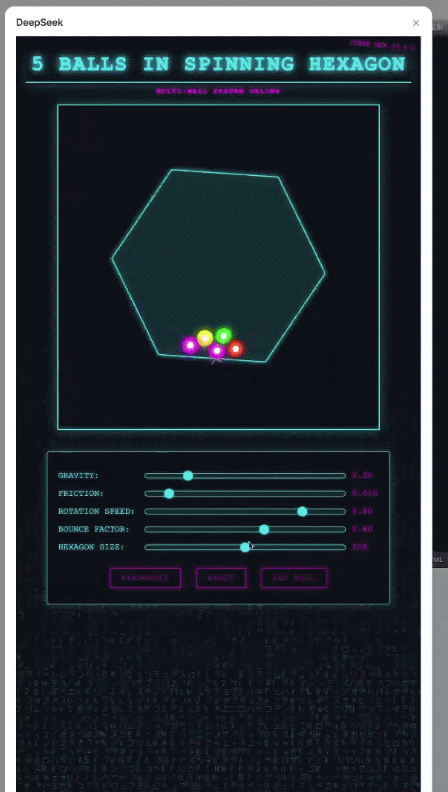

프론트엔드 웹 개발 능력 향상

단순한 UI 구성 코드를 넘어서, 디자인적으로 완성도 높은 결과물 생성이 가능해졌습니다.

- 코드 실행 가능성(executability) 개선

- 웹페이지 및 게임 프론트엔드의 시각적 완성도 향상

DeepSeek V3 0324로 향상시킨 게임 UI. 출처: DeepSeek

중국어 작문 능력 강화

문체, 내용 구성, 표현력이 한층 다듬어진 모습입니다.

- R1 스타일에 부합하는 더 자연스러운 문체

- 중·장문 작성에서 더 높은 일관성과 품질 확보

기능적 개선 사항들

실제 사용자가 자주 활용하는 영역에서의 개선은, 딥시크가 단순 연구용 모델을 넘어 ‘실전형’ LLM으로 발전 중임을 보여줍니다.

- 다중 턴 대화 기반의 리라이팅 성능 향상

- 번역 품질 개선 & 편지 작성 능력 강화

- 중국어 기반 검색 시 더 상세한 보고서 분석 결과 제공

- Function Calling 정확도 향상 (이전 버전의 문제점 보완)

DeepSeek-V3-0324는 단순한 성능 개선을 넘어, AI가 실제로 사고하고, 문제를 이해하며, 논리적으로 해결해나가는 방향으로 진화하고 있음을 증명하는 중요한 업데이트입니다.

LLM은 이제 단순 텍스트 생성 모델이 아닙니다. 전문가 수준의 지식 활용, 수학·코딩 문제 해결, 자연스러운 글쓰기와 기능 사용 능력이 LLM의 진짜 경쟁력이 되고 있습니다.

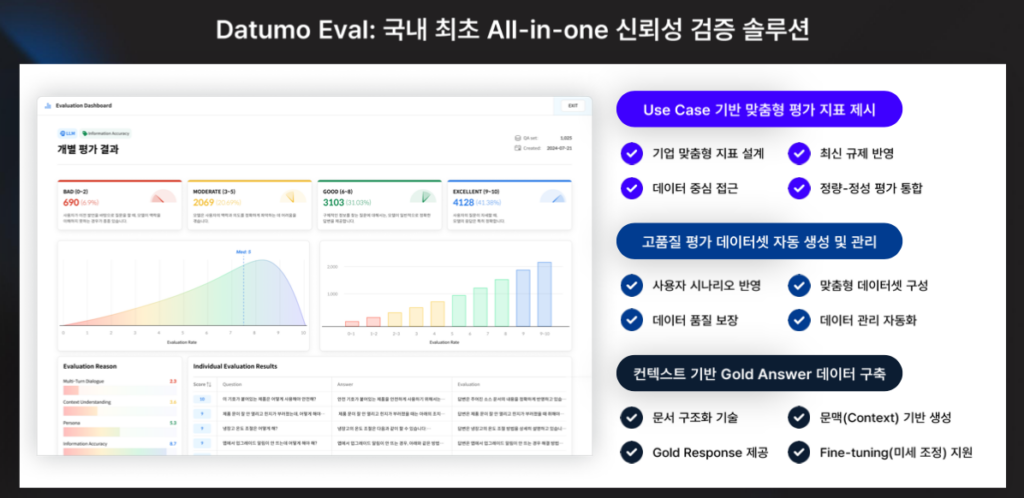

셀렉트스타의 다투모 이밸은 LLM이 목적에 맞게 임무를 잘 수행하는지 확인할 수 있는 올인원 AI 신뢰성 평가 플랫폼입니다. 경쟁력 있는 서비스를 원하신다면 언제는 편하게 문의 주시기 바랍니다.