AI가 이미지를 이해하고 언어로 표현하는 능력이 점점 좋아지고 있습니다. 하지만 사람처럼 문맥을 파악하고, 이전에 본 정보를 새로운 상황에 적용하는 능력은 여전히 부족한데요. 이번 ICCV 2025에서 발표된 논문 <Teaching VLMs to Localize Specific Objects from In-Context Examples>는 이 한계를 해결하고자 합니다. 연구진은 대형 비전-언어 모델(Vision-Language Model, VLM)에 '문맥 기반 개인화된 객체 탐지' 능력을 학습시키는 방법을 제시했는데요. 과연, 어떤 결과가 나왔을까요?

아이디어

이번 실험은 간단한 질문에서 시작합니다:

VLM은 '우리집 고양이 스누프킨' 사진을 몇 장 본 다음,

다른 사진 속에서도 스누프킨을 찾아낼 수 있을까?🧐

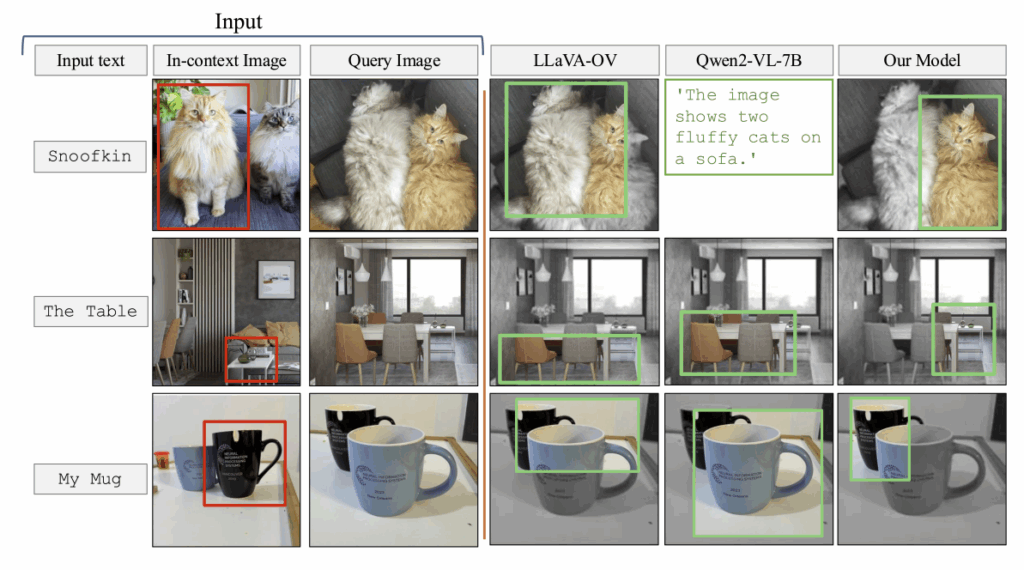

현재의 VLM은 '고양이'나 '비행기'처럼 일반적인 범주를 구분하는 데는 뛰어나지만, '특정 고양이'나 '문맥 속에서 의미가 달라지는 사물'을 찾는 데에는 약한데요. 연구진은 "few-shot personalized localization", 즉 몇 개의 예시만으로 특정 객체를 새로운 장면에서 찾아내는 능력을 학습시키는 방법을 제안했습니다.

IPLoc을 통한 객체 탐지 사례. 출처:논문.

위 그림에서 In-context Image는 찾아야 하는 객체를 표시한 데이터, Query Image는 객체를 탐지해야 하는 사진입니다. 모델은 예시 이미지에서 본 것과 같은 객체를 질의 이미지 속에서 찾아내야 하지요. 연구진의 방식을 적용한 Our Model은 찾아야 하는 객체를 알맞게 탐지한 것 같죠?

실험

"AI에게 문맥을 가르치려면, 문맥이 담긴 데이터를 제공해야 한다"고 믿는 연구진은 새로운 모델 구조를 만드는 대신, 새로운 학습 전략을 세웠습니다. 데이터를 중심으로 모델의 문맥 이해 능력을 확장하는 방식인데요. 'Data-centric' 접근을 통해 기존 VLM이 문맥을 이해하도록 만드는 IPLoc (In-context Personalized Localization) 기법을 사용했습니다. 실험 방식을 볼까요?

1. 비디오 객체 추적 데이터

연구진은 모델이 동일한 객체를 여러 장면에서 추적하는 경험을 해보도록, 다음 세 가지 대규모 비디오 추적 데이터를 사용했습니다.

- TAO (Tracking Any Object): 839개 카테고리, 복잡한 다객체 추적 데이터

- LaSOT: 장시간(평균 2,500프레임) 동안 한 객체를 지속적으로 추적

- GOT-10k: 10,000개의 실제 환경 객체 시퀀스

이 데이터들은 하나의 동일한 객체가 다양한 조명, 각도, 배경에서 등장하기 때문에, 모델이 단순히 '무엇인지' 알 수 있을 뿐만 아니라, 같은 대상을 다른 조건에서 인식하는 법 자체를 배우기에 적합합니다. 카테고리 암기가 아니라 문맥 기반 일반화 능력을 익힐 수 있지요.

2. 대화형 학습 포맷

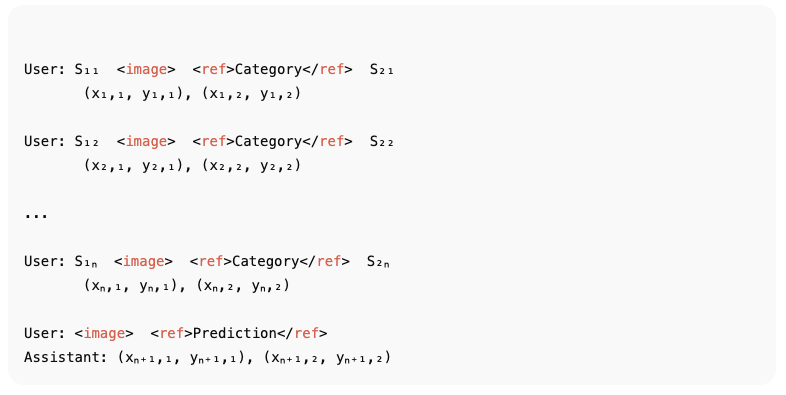

IPLoc은 데이터를 대화 형태로 재구성한다는 특징이 있는데요. 아래 예시를 볼까요?

위 구조는 모델이 여러 개의 인컨텍스트(in-context) 예시를 순차적으로 입력받은 뒤, 마지막 단계의 'Prediction' 요청에 대해 동일한 객체의 위치를 예측하는 과정을 보여줍니다. 사용자는 앞선 n개의 예시 이미지와 해당 객체의 좌표를 제공하고, 마지막에 "이 이미지에서 같은 객체를 찾아보라"고 요청합니다. 모델(Assistant)은 지금까지 제공받은 정보를 문맥으로 활용해 예측된 바운딩 박스 좌표를 출력하게 되지요. 결국 모델은 앞서 본 예시들을 일종의 '대화 맥락'으로 삼아, 마지막 이미지 속에서 같은 객체를 추론합니다.

매주 이런 AI 이야기를 받아보고 싶다면?

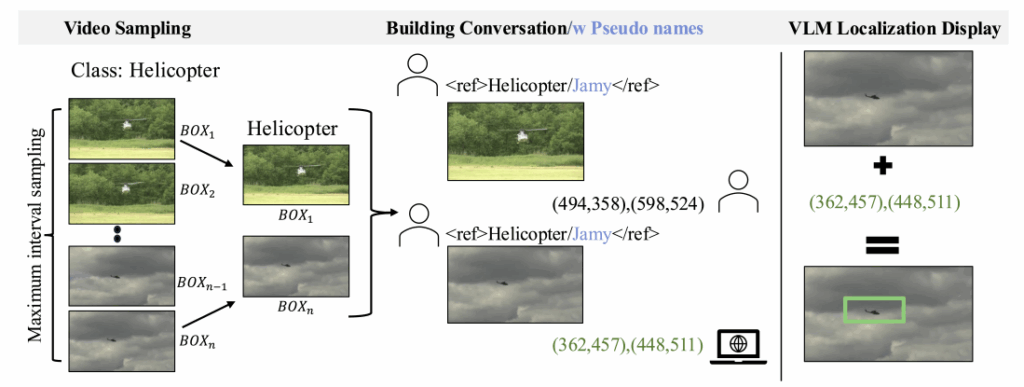

3. 가짜 이름 규제

여기에 한 가지 기발한 아이디어가 더해집니다. 모델이 개체에 대한 사전 지식에만 의존하지 않도록, 객체 이름을 무의미한 가짜 이름으로 바꾸는 건데요. 예를 들어 ‘고양이’를 ‘스누프킨’으로 바꾸면 모델은 더 이상 ‘고양이’라는 개념에 기대지 않고, 오직 시각적 유사성만을 근거로 판단하게 되겠죠? 이 과정은 모델이 언어적 정의가 아닌 문맥적 유사성에 기반해 학습하도록 유도합니다.

IPLoc의 데이터 생성 및 대화 구조 개요. 중간에 하늘색으로 가짜 이름인 ‘Jamy’를 쓴 것을 볼 수 있다. 출처: 논문.

4. 미세조정

효율적인 학습을 위해 LoRA(Low-Rank Adaptation) 방식도 함께 적용됐는데요. LoRA는 모델 전체를 새로 학습시키지 않고, 파라미터 일부만 조정하여 기존 능력을 유지하면서 새로운 능력을 추가하는 방법입니다. 덕분에 모델은 기존의 언어적 이해력이나 시각적 지식을 잃지 않으면서도, 추가로 개인화된 문맥 학습을 수행할 수 있게 되었지요.

결과

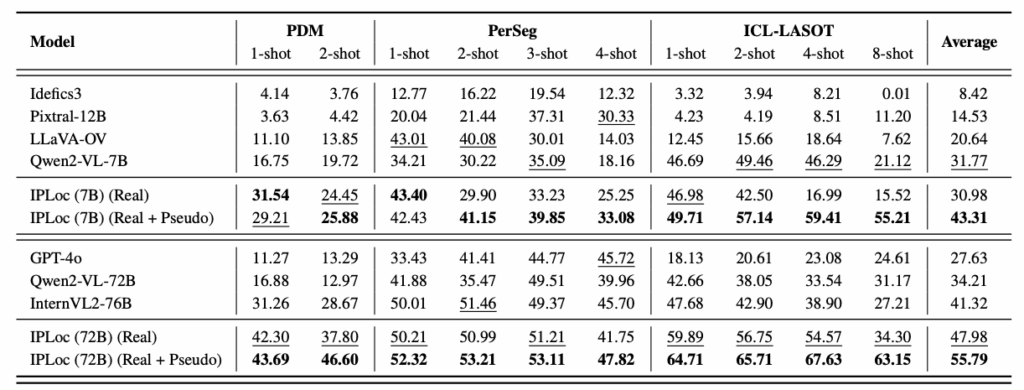

연구진은 Qwen2-VL 모델에 IPLoc을 적용했습니다. 이후 GPT-4o, LLaVA, Idefics 등 기존 모델들과 성능을 비교했지요. 비교를 위해 사용한 데이터셋으로는 PDM, PerSeg, 그리고 ICL-LASOT이 있습니다. 결과를 볼까요?

IPLoc 성능 비교. 출처: 논문.

GPT-4o는 설명은 잘했지만 실제 좌표 예측에는 약한 모습을 보였습니다. 반면 Qwen2-VL 기반 모델은 IPLoc 적용 후 평균 IoU가 31.8%에서 43.3%로 상승했는데요. 더 큰 모델(72B 파라미터)에서는 55.8%까지 올라갔습니다. 또한, 같은 크기의 모델이라도 IPLoc을 적용하지 않은 경우보다 약 20% 성능 향상이 나타났습니다.

장점이 명확한만큼, 한계도 뚜렷한데요. 현재 IPLoc은 한 번에 하나의 객체만 찾습니다. 따라서 여러 객체를 동시에 다루는 멀티 오브젝트 상황에서는 성능이 5.3% 수준으로 급감하는 모습을 보였는데요. 이는 현존 VLM 대부분의 공통적 한계이기도 합니다. 연구진은 향후 더 강력한 멀티모달 모델들과 결합하여, 여러 객체를 문맥적으로 구별하고 추적하는 단계로 확장시키고자 합니다.

IPLoc의 가장 큰 의미는 성능 자체보다 학습 방식에 있습니다. 이번 연구는 AI가 인간처럼 문맥을 통해 배우는 법을 탐구한 사례인데요. 모델의 크기나 연산 능력이 아니라, 데이터의 구조와 맥락성이 얼마나 중요한지를 보여줍니다. 앞으로 인공지능은 단순히 더 큰 모델을 만드는 경쟁이 아니라, ‘더 똑똑한 데이터’, 즉 문맥을 품은 데이터 경쟁으로 전환될 가능성도 제시하지요. AI도 단순 암기보다는 이해하는 게 더 중요하다니, 점점 더 인간을 닮아가는 듯합니다.