셀렉트스타의 체계적인 플랫폼 덕분에 양질의 데이터를 빠른 시간내에 수집할 수 있었습니다. 캐시미션 작업 가이드라인은 꼼꼼하게, 실제 예시들을 통해 쉽게 이해할 수 있도록 작성되어 데이터 품질에 큰 도움이 되었습니다.

결과적으로 InstaOrder 데이터셋의 정보를 활용한 네트워크가 기존 픽셀별 거리 예측 네트워크의 성능 향상에 큰 도움이 됨을 입증하였습니다.

포항공대 컴퓨터 비전 연구실

프로젝트 요약

데이터셋 구축 목적

객체 간 거리추정 모델 개선을 위한 이미지 속 객체 사이의 가림 정보 및 상대위치 정보 수집

수량

약 146만개(조합 기준), 약 900만건(답변 데이터 기준)

참여 인원

약 3000명

프로젝트 기간

2021년 2월~4월(3개월) (*협의 및 유지보수 기간 포함)

연구 결과는 ‘자연경관에서의 인스턴스별 차폐 및 깊이 순서(Instance-wise Occlusion and Depth Orders in Natural Scenes-다운)’ 논문으로 발표

객체 간 거리 추정 모델을 위한 900만 건의 데이터 만들기

거리 예측, 픽셀 기반에 객체 간 관계가 더해진다면?

이미지에서 물체 간 거리를 파악하는 기술은 컴퓨터 비전 영역에서 중요한 연구 분야입니다. 자율주행처럼 3차원 정보 인지가 필요한 영역이나 이미지 편집 등 다양한 분야에서 활용될 수 있기 때문이죠.

당연히 이에 대해 많은 연구가 진행되고 있습니다. 다만, 지금까지의 방법들은 영상(이미지)의 각 픽셀을 기반으로 정확한 거리를 예측하는 데에 초점을 맞추고 있습니다. 그 과정에서 종종 거리를 잘못 추정하는 오류가 발생하기도 합니다.

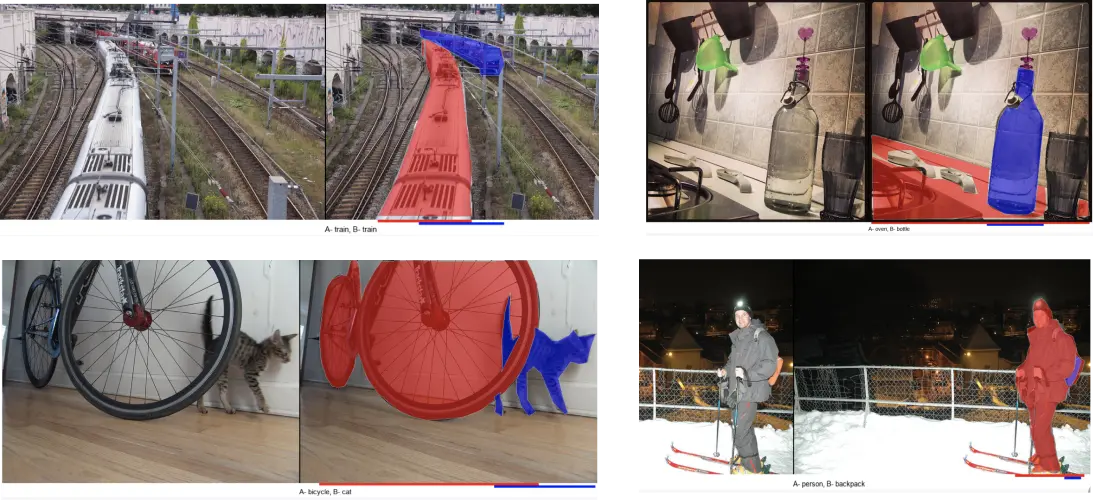

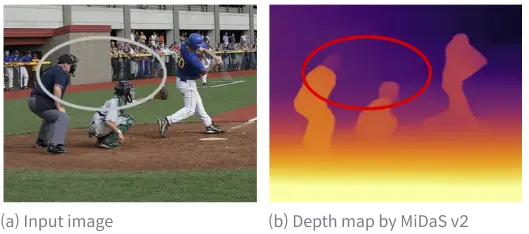

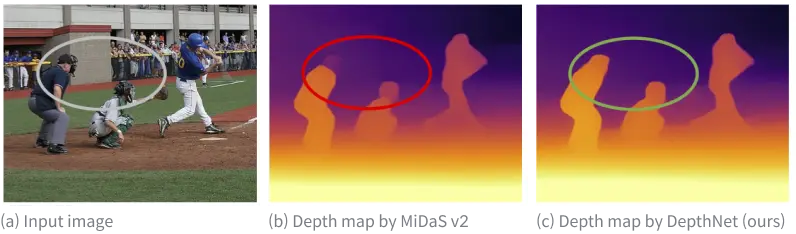

가령 아래 오른쪽 그림(b)은 세계 최고 수준의 거리 추정 방법인 MiDaS v2 네트워크로 거리를 예측한 결과입니다. 거리가 가까울수록 노란색, 멀수록 보라색으로 나타납니다.

전체적으로 물체의 거리가 잘 표시된 듯합니다. 그런데 왼쪽 두 명을 자세히 보면, 머리와 몸의 거리가 다르게 표시됐습니다. 실제로 몸과 머리는 같은 거리에 있는데 몸은 노란색, 머리는 보라색입니다. 몸은 가깝게, 머리는 멀게 인식하고 있다는 의미입니다. 완벽한 정확도는 아니지요.

이에 포항공대 컴퓨터 비전 연구실(이하 ‘포스텍 비전랩’)은 픽셀 기반의 거리 예측이 아닌, 객체 간의 관계를 기반으로 거리를 새로 정의하여 예측하는 모델을 만들기로 했습니다.

전체적으로 물체의 거리가 잘 표시된 듯합니다. 그런데 왼쪽 두 명을 자세히 보면, 머리와 몸의 거리가 다르게 표시됐습니다. 실제로 몸과 머리는 같은 거리에 있는데 몸은 노란색, 머리는 보라색입니다. 몸은 가깝게, 머리는 멀게 인식하고 있다는 의미입니다. 완벽한 정확도는 아니지요.

이에 포항공대 컴퓨터 비전 연구실(이하 ‘포스텍 비전랩’)은 픽셀 기반의 거리 예측이 아닌, 객체 간의 관계를 기반으로 거리를 새로 정의하여 예측하는 모델을 만들기로 했습니다.

‘누가 더 앞에 있을까?’가 어려운 두 가지 이유

셀렉트스타와 비전랩은 이미지 속 물체들의 공간적인 거리 정보가 담긴 데이터셋 ‘InstaOrder’ 데이터셋을 구축하고자 했습니다.(어쩐지 특정 SNS의 이름이 떠오르지만, 관계는 없습니다.)

‘InstaOrder’는 두 부분으로 나뉘어져 있습니다.

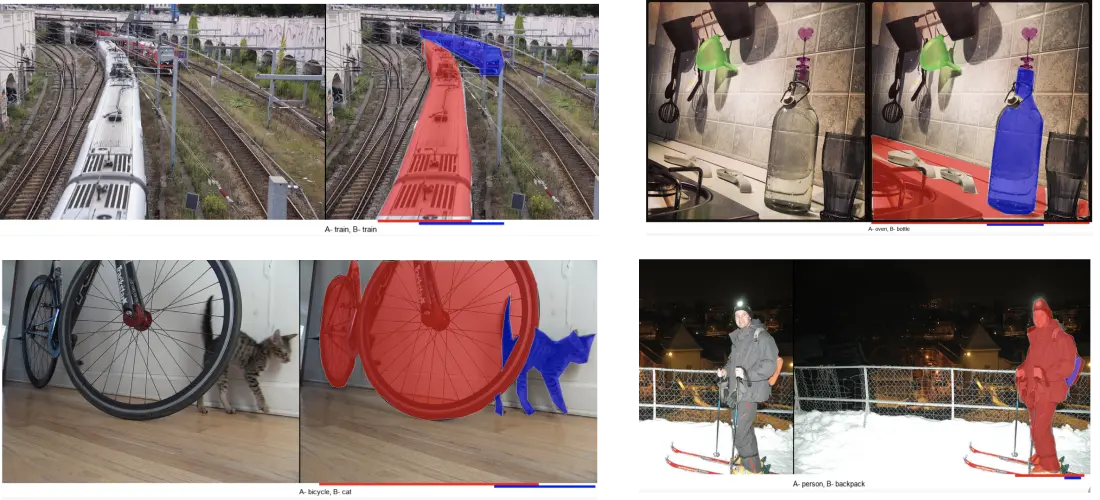

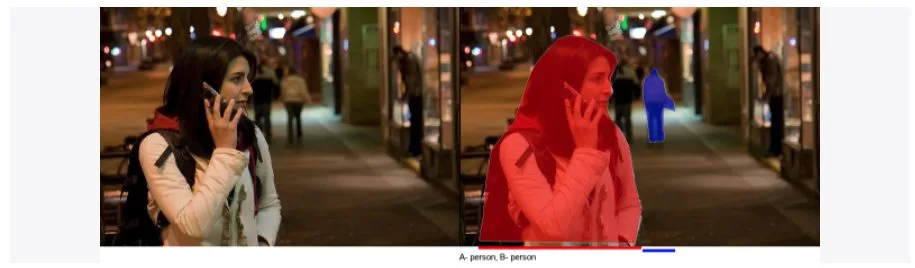

- occlusion order(가림 정보): 가려진 물체와 가리는 물체를 식별한 데이터셋

- depth order(앞뒤 순서): 물체 간 거리 순서를 설명하는 데이터셋

InstaOrder는 COCO 2017의 train, validation 이미지를 활용했습니다. 이미지 10만 장 속 57만 개 객체를 대상으로 약 146만 개의 조합(원천 데이터)을 만들었지요.

조합이란, 사진 속에 등장하는 객체 중 2개를 임의로 뽑은 것입니다. 두 객체를 보고 가림 정보와 순서 정보를 판단하게 됩니다. 한 사진에 여러 개의 조합이 있다면, 판단 결과를 합쳐 사진 속 모든 객체의 순서가 정해집니다.

*빨간색 사람(A)이 파란색 사람(B)보다 앞에 있습니다.

여기서 첫 번째 어려움이 발생합니다. 원천 데이터가 다양하기에 단순하게 누가 누구를 가리는지, 누가 앞에 있는지 판단하기 애매모호한 상황이 많습니다. 가령,

- 콜라주 혹은 합성된 사진도 가공 대상인가?

- 거울에 비친 물체의 모습도 가공 대상인가?

- 물체 일부가 보이지 않는 상태에서 물체 간의 순서 판단 기준은?

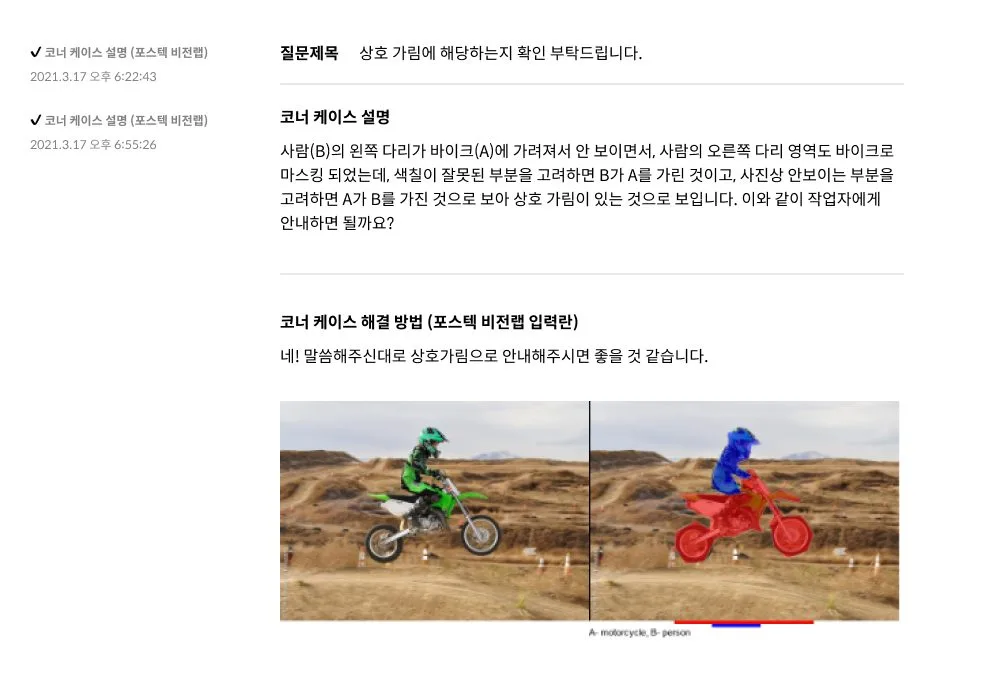

- 오토바이에 탄 사람의 옆모습처럼, 물체가 서로 엉켜 있을 때 판단 기준은?

- 페트병에 들어 있는 사탕처럼, 한 객체가 다른 객체 안에 있을 때 판단 기준은?

수많은 예외 사항까지 고려해 최대한 일관된 기준을 세워야 했습니다.

여기서 끝이 아닙니다. 오픈 데이터셋은 기본적으로 셀렉트스타의 크라우드 소싱 데이터 가공 플랫폼 캐시미션으로 만들어집니다. 146만 개 조합에 대한 위치 정보를 캐시미션으로 가공하려면 약 900만 개의 답변 데이터가 필요했습니다. 캐시미션은 불특정 다수가 참여하므로 정확하면서도 모두가 쉽게 이해할 수 있는 가이드라인도 필요했습니다.

기준의 명확성과 작업의 정확성, 두 마리 토끼를 잡기 위해 ‘가이드 담당자’가 출동합니다.

셀렉트스타에서는 여러 팀이 협업해 캐시미션에 데이터 가공 작업을 오픈합니다. ‘가이드 팀’은 데이터의 정확성과 일관성을 담당하는 큰 축으로, 고객사와 크라우드 소싱 작업자를 연결하는 다리 역할입니다. 코너케이스(예외 상황)를 발굴해 데이터셋의 의도에 최적화된 기준을 세우고, 이를 명확하게 전달하는 가이드라인을 제작합니다.

이번에도 가이드 담당자가 함께 비전랩과 작업 기준을 협의하고, 가이드라인(설명서)을 제작했습니다.

가이드 담당자는 ‘실시간 협의 문서’를 통해 비전랩과 가공 기준을 만들어 나갔습니다.

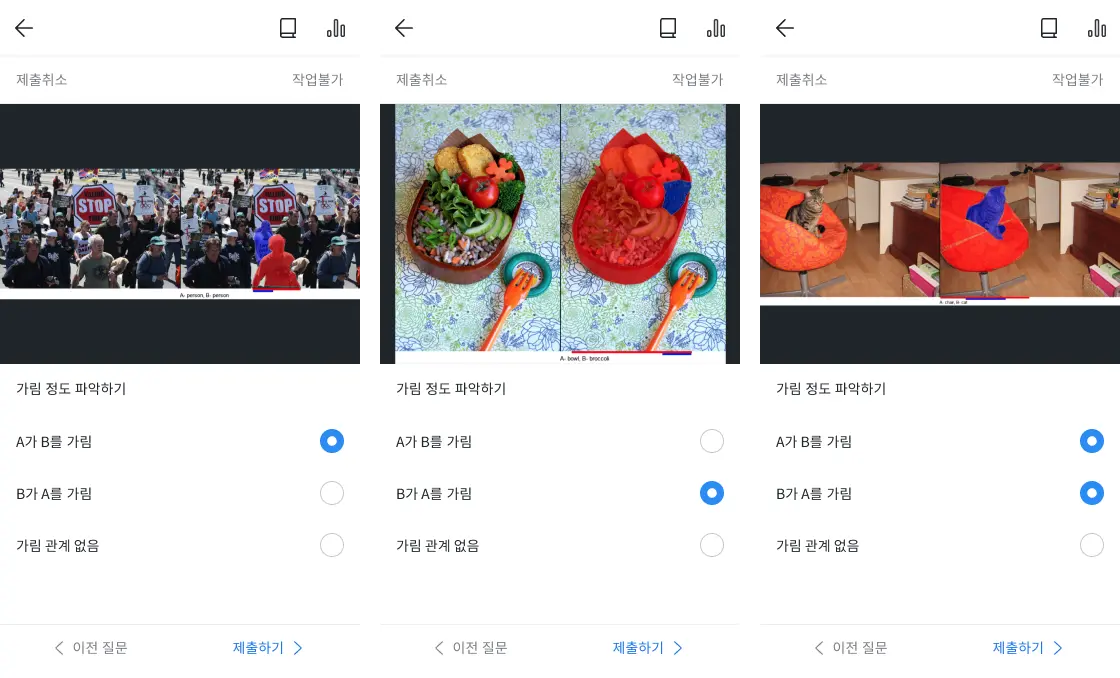

‘캐시미션(앱)’에서 ‘가림 정도 파악하기’ 미션 수집, 가공 작업 진행 화면

그리고 마침내 약 한 달간의 협의 기간을 거쳐 캐시미션에 ‘가림 정보 파악히기’ ‘상대 위치 파악하기’라는 이름의 작업(미션)이 오픈되었습니다.

결과는 어땠을까요?

6주 900만-오류율 0.8%, 모델 개선, 국제 학술대회까지, 성공적

조합 개수 : 1,465,566개 (상대 위치&멀티레인지, 가림정보 각각)

SUM(사진 내 객체*C*2)= 1,465,566 객체 조합

img_file_name: COCO DATASET 2017 TRAIN 및 VALIDATION파일의

`img_id`_`object1_id`_ `object2_id`.png

– object1_id : 왼쪽 객체 / object2_id : 오른쪽 객체

다음의 경우 object에서 제외함

– 한 사진에 객체 하나만 존재하는 경우

– area <= 600

– iscrowd = 1

다음의 경우 사진 내 object 중 10개를 랜덤으로 선택하여 진행

– 한 사진에 object가 10개를 초과하는 경우

count

– 해당 데이터가 결정되기까지 참여한 유저 수

크라우드 소싱 데이터 가공의 가장 큰 장점은 속도입니다. 작업이 캐시미션에 오픈된 뒤 약 3000명의 캐시미션 유저가 참여했고, ‘가림 정보’는 1주일 만에 약 300만 건, ‘앞뒤 정보’는 6주 만에 약 600만 건의 답변 데이터가 제출됐습니다.

속도와 반대로, 정확도는 크라우스 소싱 가공을 고려할 때 걱정되는 부분입니다. 이번 프로젝트에서는 그 걱정을 뛰어넘어 0.8%의 오류율을 기록했습니다.

이번 프로젝트에서 가장 중요한 오류는 객체 순서가 끝없이 반복되는 결과였습니다. 예를 들어,

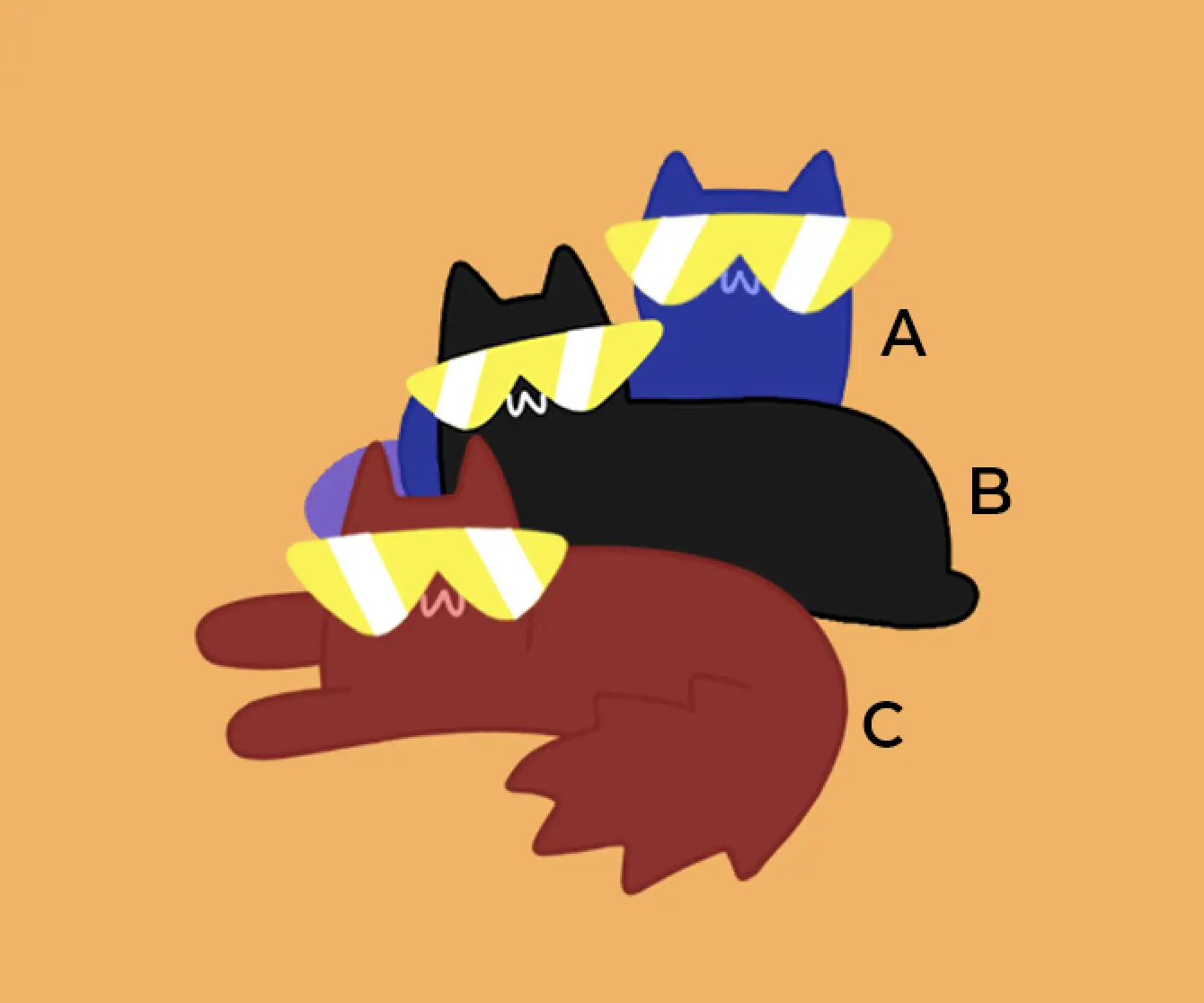

사진에 A, B, C 객체가 있다면 세 개의 조합이 존재합니다.

조합1 : A, B 간 상대 위치 비교

조합2 : B, C 간 상대 위치 비교

조합3 : A, C 간 상대 위치 비교

유저들의 답변으로 결정된 각 조합의 답이 아래와 같을 때,

- 조합1 : A < B (B가 A보다 앞에 있음)

- 조합2 : B < C (C가 B보다 앞에 있음)

조합3에서 C가 A보다 앞에 있어야 합니다. 그런데 유저의 답변이

- 조합3 : C < A(A가 C보다 앞에 있음)

라면 논리적으로 맞지 않은 결과가 도출됩니다.

“A < B < C < A < B < C … ” 인 상태가 영원히 반복되는 것이지요.

비전랩은 위와 같은 상황은 오류로 보고, ‘cycle’이라는 이름을 붙였습니다. 146만 개의 조합 중 4%인 6만 개의 cycle이 발생했고, 재작업을 진행했습니다.

앞서 언급한 대로 이번 프로젝트 특성 상, 위치 정보 관계를 명확하게 따지기에는 애매한 엣지케이스가 너무 다양하게 존재하고, ‘판단자(유저) 주관’이 필요한 부분이 있기에 전체 조합의 0.8%, 1.3만 개의 cycle이 존재하는 것으로 마무리되었습니다.

결과적으로 비전랩 측에 따르면, 기존 픽셀별 거리 예측 네트워크는 InstaOrder 데이터셋을 학습한 이후 성능이 크게 향상됐다고 합니다. 그리고 InstaOrder 데이터셋 연구 결과는 지난해 11월 30일 아카이브를 통해 ‘자연경관에서의 인스턴스별 차폐 및 깊이 순서(Instance-wise Occlusion and Depth Orders in Natural Scenes-다운)’란 제목으로 공개됐습니다.

또한, 아주 기쁘게도 해당 논문은 올해 6월 19일부터 24일까지 미국 루이지애나 뉴올리언스에서 열리는 국제 컴퓨터 비전 및 패턴인식 학술대회(CVPR2022, Conference on Computer Vision and Pattern Recognition)에서 발표될 예정입니다.

셀렉트스타만의 데이터 생산 프로세스와 노하우를 기반으로 만들어진 정확하고 명확한 가이드라인, 여기에 크라우드 소싱 가공의 장점이 합쳐져 이뤄낸 성과라고 생각됩니다.

셀렉트스타는 앞으로 InstaOrder 같은 사례가 많아지길 바랍니다. AI업계가 건강하게 발전하기를요.(셀렉트스타도요!) 그래서 오픈 데이터셋 프로젝트를 통해 무료로 데이터셋 구축을 지원하고, 데이터셋을 공개하고 있습니다.

올해도 셀렉트스타는 오픈 데이터셋 프로젝트를 진행합니다. 아직은 어떤 데이터셋인지 공개되진 않았지만 꾸준히 캐시미션을 보신다면, 힌트를 얻을 수 있을지도 몰라요. 올해는 어떤 재미있고, 의미 있는 프로젝트가 나타날지 지켜봐 주세요

* InstaOrder 데이터셋을 직접 보고 싶다면? https://open.selectstar.ai/ko/instaorder 를 확인해 주세요.

참고 자료

http://www.aitimes.kr/news/articleView.html?idxno=24533