레이블이 없는 데이터에서 스스로 레이블을 생성해 학습하는 방법인 자기지도학습(SSL)은 지난 몇 년 동안 이미지, 텍스트, 음성 등 다양한 분야에서 학습 방식으로 사용됐습니다. 하지만 자기지도학습에는 오랫동안 해결되지 않은 구조적 문제가 있는데요. 바로 '임베딩 공간의 붕괴'와 '기하학적 왜곡'입니다.

이 문제를 보다 근본적이고 안정적인 방식으로 해결하려는 시도로 등장한 프레임워크가 LeJEPA입니다. 복잡한 기술적 장치를 덕지덕지 붙이는 대신, 이론적 근거를 바탕으로 구조 자체를 다시 설계했다고 하데요. 얀 르쿤이 메타를 떠나기 전 마지막으로 발표한 논문으로 보이는 <LeJEPA: Provable and Scalable Self-Supervised Learning Without the Heuristics>를 함께 살펴볼까요?

SSL의 문제점을 알아보자

자기지도학습 모델들은 입력의 의미(semantic)를 잘 구분합니다. 고양이는 고양이끼리, 자동차는 자동차끼리 자연스럽게 모이도록 임베딩을 형성하지요. 그러나 이런 모델들은 두 가지 근본적인 문제를 피하지 못합니다.

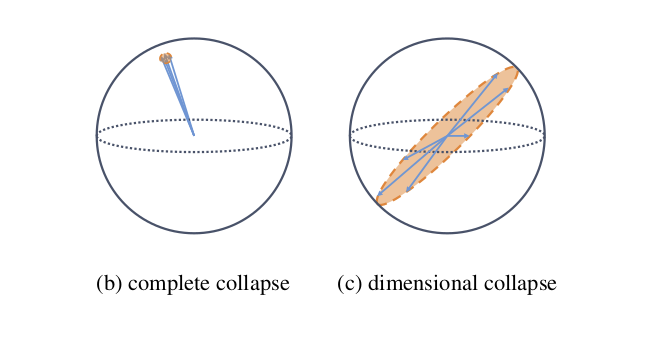

두 가지 붕괴. 출처: velog@jaeheon-lee.

- 완전한 붕괴 (Complete collapse)

완전한 붕괴란 모델이 모든 입력을 거의 동일한 벡터로 출력하는 현상입니다. 모델이 의미 있는 표현을 학습하는 대신, 손실을 사장 쉽게 최소화하는 벡터값 쪽으로 치우치는 현상인데요. 이렇게 되면 되면 입력 간 분별력이 사라져 임베딩은 사실상 무용해집니다. - 차원 붕괴 (Dimensional collapse)

차원 붕괴란 임베딩 공간이 특정 방향으로는 과도하게 퍼지고, 다른 방향에서는 거의 변화가 없는 상태를 말합니다. 임베딩이 전체 차원을 고르게 사용하지 못해, 몇 개의 유효 차원만 남는 형태로 수축되는 현상이지요. 임베딩 형태가 비대칭해지면 의미적 구조는 남아 있어도 표현 공간 자체가 왜곡되는데요. 이런 왜곡은 다운스트림 태스크에서 성능 불안정, 도메인 전이 실패, 특정 특징(feature)에 대한 과도한 의존 등 다양한 문제를 일으킵니다.

붕괴를 막기 위해 기존 SSL들은 teacher–student 구조, stop-gradient, EMA 업데이트 등 복잡한 안정화 장치를 붙여야만 했습니다. 다시 말해, 기존 SSL은 '잘 되지만 구조적으로 매우 불안정하기 때문에 많은 보조 기계장치를 필요로 하는 방식'이었죠.

SIGReg: 그래도 모양을 좀 잡아야지...

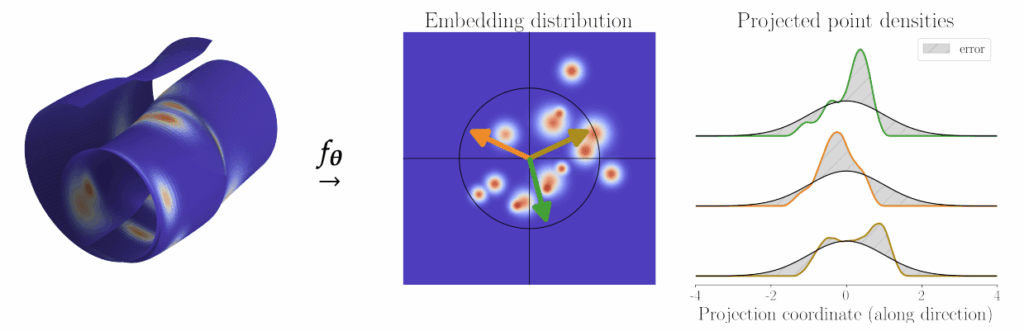

반쪽짜리 표현이 아닌, 온전한 표현을 구현하기 위해, 연구진은 SIGReg(Sketched Isotropic Gaussian Regularization)를 제안합니다. JePA의 약점을 해결하기 위해 고안된 새로운 정규화 방식이지요. 아이디어는 간단한데요. SIGReg는 임베딩을 여러 무작위 방향으로 투영한 뒤, 그 투영된 분포가 이상적인 등방성 가우시안(Isotropic Gaussian) 모양과 얼마나 다른지를 측정합니다. 여기서 등방성 가우시안이란 모든 방향에서 동일하게 퍼진 동그란 분포를 의미합니다. SIGReg는 이후 등방성 가우시안과의 차이를 줄이는 방향으로 손실을 추가하는데요. 이 과정을 반복하면 임베딩은 자연스럽게 균일하게 둥근 모양이 되며, 모델은 학습 과정에서 아래 조건을 만족하게 됩니다:

- 임베딩의 모든 방향에서 variance가 살아 있다

- 특정 방향이 과도하게 강조되지 않는다

- 특정 방향이 죽어서 variance가 0이 되는 일도 없다

- 전체 공간이 균형 있는 '둥근 모양'을 유지한다

- collapse가 구조적으로 발생할 수 없는 상태가 된다!

SIGReg가 임베딩 공간 모양을 둥글게(isotropic) 만드는 방법. 출처: 논문.

여기서 중요한 점은, SIGReg는 임베딩을 직접 조작하는 방식이 아니라, 모델 파라미터가 업데이트되는 방향을 제어하는 학습 규칙이라는 점입니다. 즉, semantic은 JePA가 안정적으로 유지하고, geometry는 SIGReg가 단단히 잡아주는 형태지요.

가장 빠른 AI 뉴스

LeJEPA: 의미도 모양도 다 중요해!

LeJEPA는 JePA와 SIGReg를 결합해 만든 새로운 SSL 프레임워크입니다. 앞서 언급했듯이, JEPA는 이미지의 의미적 구조를 학습하는 데 강점이 있지만, 임베딩 공간의 기하학적 균형을 스스로 유지하지는 못합니다. SIGReg는 이 부분을 보완해, 임베딩 공간이 특정 방향으로 치우치지 않고 모든 방향에서 고르게 분포되도록 정규화하는 역할을 합니다.

기존 SSL은 의미 학습과 공간 안정화를 하나의 복잡한 구조 안에서 동시에 해결하려 했기 때문에 teacher–student, EMA, predictor 같은 여러 안정화 장치가 필요했는데요. LeJEPA는 이 두 기능을 명확하게 분리함으로써 훨씬 단순한 구조로도 붕괴 없이 학습이 가능해졌고, 임베딩 공간의 균형이 유지되기 때문에 도메인이 달라져도 안정적으로 적응할 수 있습니다. 성능 측면에서도 JePA의 강점이 강화되어 의미 구조가 더 선명해졌지요. 또 초대형 모델에서도 붕괴하지 않고 안정적으로 학습되며, 실제 실험에서도 뚜렷한 우위를 보였습니다.

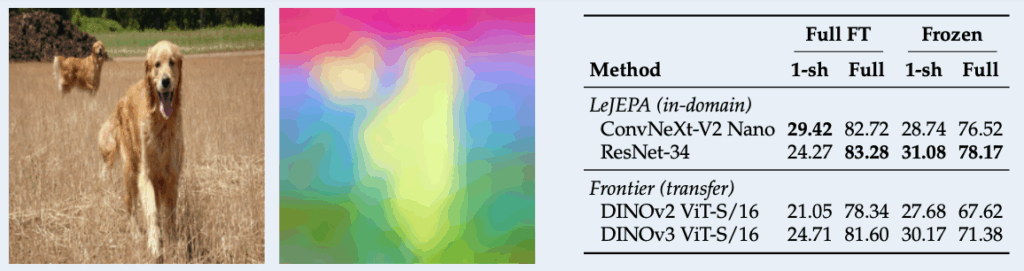

학습 과정에서도 특징적인 장점이 나타났는데요. LeJEPA는 학습 중 손실 값이 떨어질 때 분류나 전이학습 같은 다운스트림 태스크의 성능도 함께 좋아지는, 드문 유형의 SSL입니다. 기존 SSL들은 손실 값이 아무리 잘 내려가도 실제 성능과 상관이 없는 경우가 많아 모델이 제대로 배우는지 훈련 중에는 판단하기 어려웠는데요. LeJEPA는 손실 값 곡선만 봐도 모델이 올바른 방향으로 학습하고 있는지 바로 확인할 수 있습니다. 또한 PCA에서도 의미별 클러스터가 또렷하게 분리되었으며, 특히 Galaxy10처럼 완전히 다른 도메인에서는 DINOv2·DINOv3 같은 초대형 파운데이션 모델을 앞서는 성능을 보여주었습니다.

LeJEPA 임베딩의 PCA 시각화, 오른쪽: Galaxy10 도메인에서의 LeJEPA 성능 비교. 출처: 논문.

LeJEPA는 의미 중심의 시맨틱 학습(JEPA)과 임베딩 형태 안정화(SIGReg)를 분리해 결합한 결과입니다. 기존 SSL의 복잡한 장치를 대부분 제거하면서도, 붕괴 없이 안정적으로 학습할 수 있는 표현을 만들지요. 임베딩 공간이 균형 있게 유지되기 때문에 도메인이 바뀌어도 표현 품질이 크게 흔들리지 않고, 텍스트나 음성, 멀티모달 등 임베딩이 존재하는 어떤 데이터에도 (이론상으로) 적용할 수 있습니다. LeJEPA는 ‘어떤 방식으로 SSL을 설계해야 안정성과 표현력을 동시에 확보할 수 있는가’에 대한 실용적인 해답을 제시합니다.

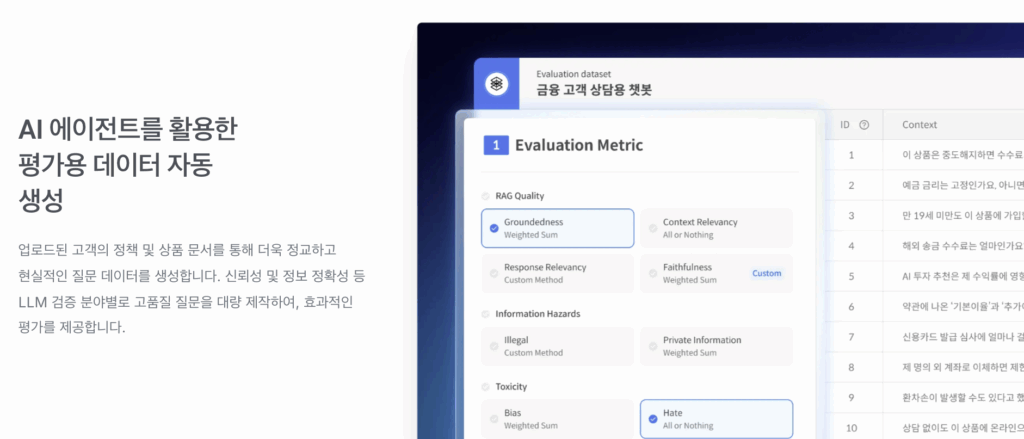

셀렉트스타는 AI 에이전트를 활용해 AI 안전성을 평가하는 플랫폼, 다투모 이밸을 개발했습니다. 덕분에 안전한 AI인지 테스트하기 위한 평가용 데이터를 자동으로 생성할 수 있는데요. 원하는 지표에 맞춰 원하는대로, 원하는만큼 AI를 테스트하고 결과를 분석하고 싶다면 셀렉트스타를 찾아주세요!