소설도 쓰고 복잡한 코드도 짜는 AI지만, 여전히 극복하지 못한 약점이 하나 있었습니다. 바로 ‘너무 긴 글은 기억하지 못한다’는 점인데요. 너무 긴 글을 받은 AI는 기존 RNN의 정보 손실로 인해 앞부분 내용을 잊어버리거나, 트랜스포머의 계산 비용이 감당 못 할 정도로 올라가는 문제가 있었습니다.

이에 구글은 AI가 정보를 처리하는 근본적인 방식을 뜯어고쳤습니다. 바로 Titans 아키텍처와 MIRAS 프레임워크를 통해서인데요. 덕분에 AI는 200만 단어가 넘는 대화를 생생하게 기억하며, 기존 모델들을 압도하는 성능을 냈습니다. 좀 더 자세히 알아볼까요?

Titans: 단순 저장이 아닌, 실시간 공부

기존의 AI 모델들은 긴 글을 읽을 때 정보를 압축해서 고정된 벡터에 구겨 넣으려 했습니다. 그러다 보니 디테일이 뭉개지기 일쑤였지요. 하지만 Titans는 다릅니다. Titans는 정보를 단순히 저장하는 게 아니라, ‘추론 시점 암기(Test-Time Memorization)’라는 기술을 통해 실시간으로 학습합니다.

매일 반복되는 일상은 쉽게 잊히지만, 출근길에 마주친 코끼리는 평생 기억하겠지요. Titans도 이 원리를 이용합니다. AI가 다음 내용을 예측했을 때 뻔한 내용이라면 과감히 흘려보내지만, 예측이 빗나간 ‘놀라운(Surprise)’ 정보가 나타나면 즉시 장기 기억 신경망을 업데이트하는데요. 모델은 예측 오차에 대한 손실 함수를 계산해 정보의 중요도를 판단합니다. 이후 기존의 단순한 행렬 메모리 대신, 다층 퍼셉트론(MLP)으로 구성된 깊은 신경망을 사용하여 복잡한 맥락을 비선형적으로 압축하고 저장합니다.

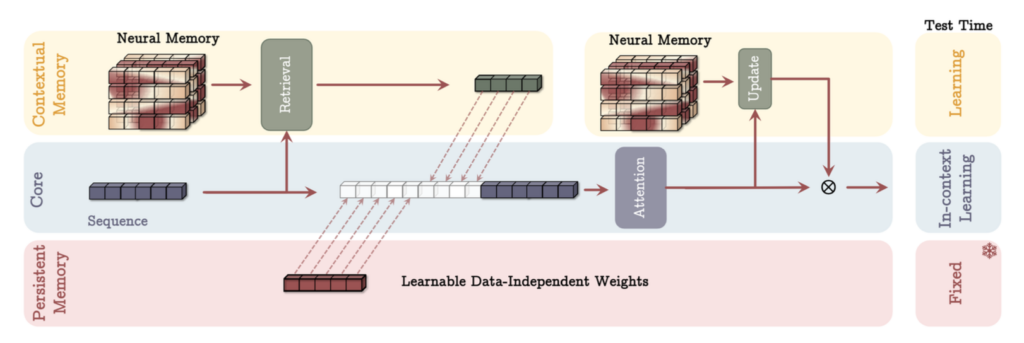

Titans의 기억 시스템을 알아보자

Titans는 인간의 뇌처럼 서로 다른 역할을 하는 세 가지 기억 시스템을 동시에 가동하여 효율성을 극대화합니다. 함께 살펴볼까요?

- Core(단기 기억): 지금 당장 읽고 있는 문장을 처리하는 집중력입니다. 주로 어텐션 메커니즘이 이 역할을 맡아 현재의 정보를 정밀하게 분석합니다.

- Long-term Memory(장기 기억): 과거의 방대한 맥락을 압축해 둔 심층 신경망입니다. 위에서 설명한 '놀라움'을 통해 실시간으로 업데이트되는 Titans의 핵심 엔진입니다.

- Persistent Memory(영구 기억): 태스크 수행에 필요한 문법 지식이나 상식처럼, 입력 데이터와 상관없이 고정되어 있는 지식입니다.

위 세 가지 기억 시스템은 어떻게 조립하느냐에 따라 각각 조금씩 다른 특징을 보이는데요. 간단하게 알아보겠습니다.

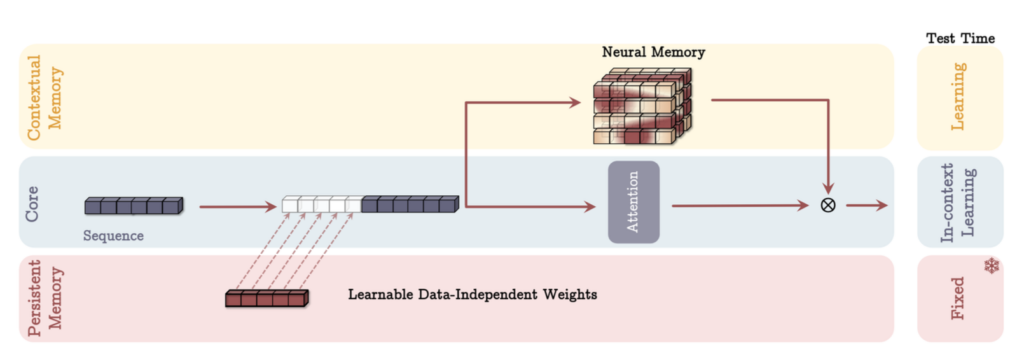

- MAC (Memory as Context)

과거의 방대한 기억을 압축해서 현재 문맥의 앞에 붙여줍니다. 마치 시험 볼 때 '핵심 요약 노트'를 옆에 두고 문제를 푸는 것과 같지요. 데이터 간의 의존 관계가 길 때 가장 강력한 성능을 발휘하는데요. 어텐션이 ‘이건 기억에서 가져와야겠다!’를 직접 판단할 수 있어 메모리 효율이 좋습니다.

Titans의 MAC 아키텍처. 출처: 구글.

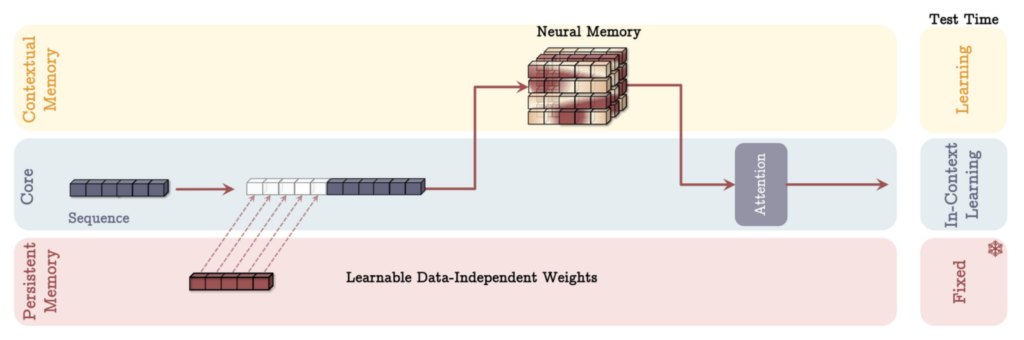

- MAG (Memory as Gate)

단기 기억과 장기 기억이 동시에 돌아갑니다. 마지막에 문지기가 두 정보를 적절한 비율로 섞어주는데요. 단기 기억은 '정밀한 최근 정보'를, 장기 기억은 '전체적인 흐름'을 맡는 역할 분담이 확실합니다. 언어 모델링 등 일반적인 태스크에서 준수한 성능을 보입니다.

Titans의 MAG 아키텍처. 출처: 구글.

- MAL (Memory as Layer)

정보를 먼저 장기 기억 필터에 통과시킨 다음, 그 결과를 단기 기억에 넘겨주는 순차적 층 구조입니다. 기존의 하이브리드 모델들과 가장 유사한 방식이지요. 학습 및 처리 속도가 가장 빠른 대신, 층이 분리되어 있어 정보의 상호 보완 능력은 MAC보다 다소 떨어질 수 있습니다.

Titans의 MAL 아키텍처. 출처: 구글.

가장 빠른 AI 뉴스

MIRAS: AI 기억력을 설계하는 설계도

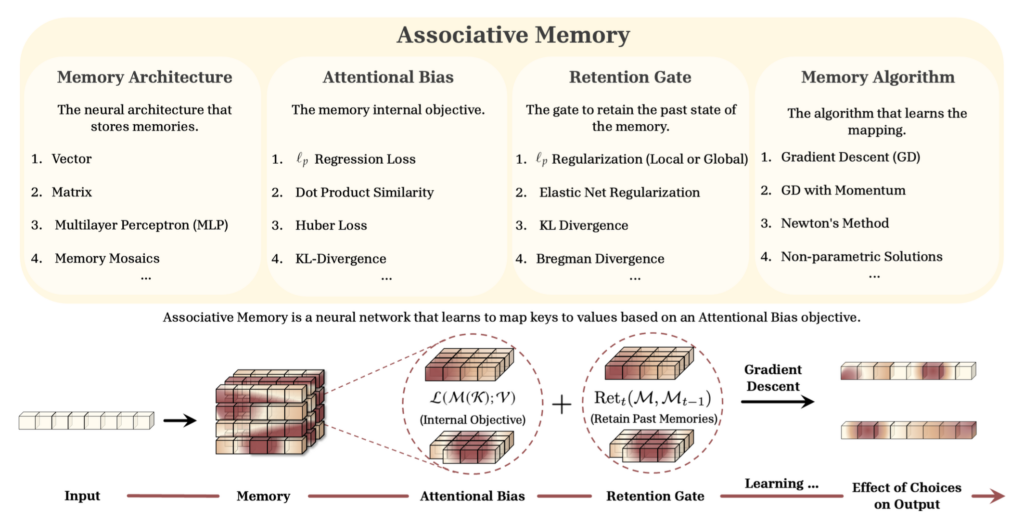

Titans가 자동차라면, MIRAS는 그 차를 만들기 위한 ‘공학 설계도’라고 볼 수 있는데요. 연구진은 시퀀스 모델링을 최적화 문제로 재정의하고, 모든 기억 모델이 메모리 구조, 주의 편향, 유지 게이트, 그리고 메모리 알고리즘이라는 네 가지 부품으로 ‘조립’된다는 것을 발견했습니다.

MIRAS 개요. 출처: 구글.

- 메모리 아키텍처: 모델이 얼마나 기억할 수 있는지(용량)를 결정합니다.

- 주의 편향: 데이터 안의 숨겨진 패턴을 어떻게 모델링할지 담당합니다.

- 유지 게이트: 새로운 것을 배우는 것과 과거를 기억하는 것 사이의 균형을 조절합니다.

- 메모리 학습 알고리즘: 기억을 어떻게 관리하고 업데이트할지 책임집니다.

이 설계도가 중요한 이유는, 데이터의 특성에 따라 AI의 기억 방식을 최적화할 수 있기 때문인데요. 연구진은 MIRAS 프레임워크를 활용해 기존의 단순한 방식을 넘어선, 더욱 똑똑한 기억 관리 모델 세 가지를 제안합니다.

MONETA

세상의 데이터는 깔끔하지 않습니다. MONETA는 특정 기준을 정해 데이터에 섞인 자잘한 노이즈는 무시하고 진짜 중요한 신호만 골라내어 기억합니다. 시끄러운 카페에서도 친구 목소리만 들리는 것처럼, 불필요한 정보가 기억을 흐리는 것을 막아주지요.

YAAD

긴 문서를 읽다 보면 오타나 엉뚱한 데이터가 튀어나올 때가 있지요? 기존 AI는 이걸 억지로 학습하려다 전체 기억이 꼬이곤 했습니다. 하지만 YAAD는 Huber Loss를 사용하여 이를 해결합니다. 작은 실수는 꼼꼼하게 교정해서 배우지만, 너무 터무니없는 정보가 들어오면 ‘이건 오류구나’라고 판단하고 부드럽게 넘기지요.

MEMORA

새로운 정보를 배울 때 기존의 지식 체계가 와르르 무너지면 안 되겠지요? MEMORA는 새로운 기억이 들어와도 전체적인 지식의 분포를 해치지 않도록 조율합니다. 덕분에 학습이 계속되어도 기억이 한쪽으로 쏠리지 않고 안정적인 상태를 유지합니다.

결과는 어땠을까?

Titans와 MIRAS 변형 모델들은 기존의 최신 모델인 Transformer++, Mamba2 등과 비교해 어떤 모습을 보였을까요?

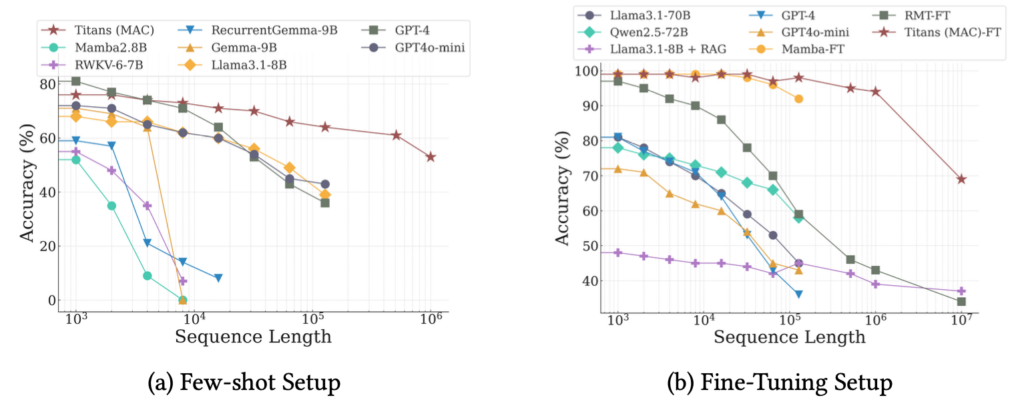

Titans는 무려 200만 토큰 이상의 문맥을 처리하면서도, 수천 페이지 문서 구석에 숨겨진 문장을 찾아내는 NIAH(Needle In A Haystack) 테스트에서 높은 정확도를 유지했습니다. 해리포터 전권이 약 140~160만 토큰으로 추정되는데요. Titans는 해리포터 전권을 거뜬하게 읽고 기억할 수 있습니다.

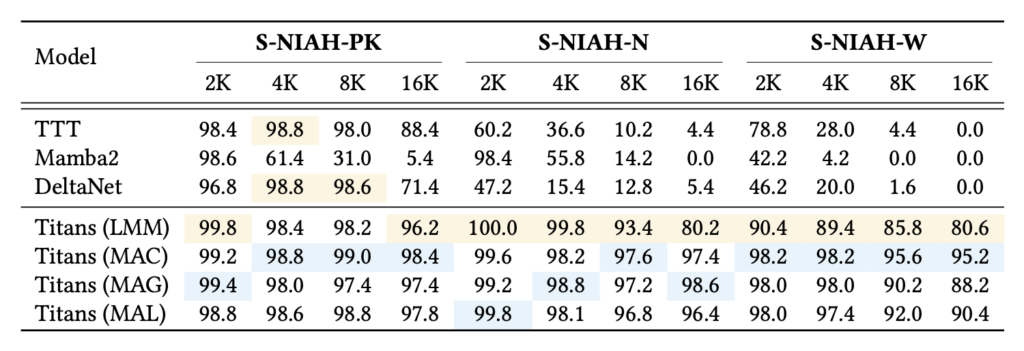

NIAH 테스트 결과. 문맥이 길어질수록(가로축) 다른 모델들의 성능은 급락하지만, Titans(MAC)는 안정적인 정확도를 유지한다. 출처: 구글.

LLM이 실제로 얼마나 긴 문맥을 효과적으로 처리할 수 있는지를 평가하는 RULER 벤치마크 기준으로 성능을 비교해 볼까요?

Titans NIAH 테스트 성능 비교. 출처: 구글.

- 💡여기서 잠깐: 그래프에 등장하는 ‘Titans(LMM)’은 장기 기억 모듈(Long-term Memory Module)의 약자입니다. 이는 Titans의 순수한 메모리 성능을 증명하기 위해, 단기 기억(Attention) 장치 없이 오직 ‘신경망 메모리’만으로 작동시킨 버전입니다.

위 테이블을 보면, Mamba2는 문서 길이가 길어지자(4K) 정확도가 61.4%로 뚝 떨어졌으며, 8K 구간에서는 31.0%까지 하락했습니다. 반면 Titans (LMM)는 Mamba2가 31.0% 정확도를 기록할 때도 98.2%를 유지했지요.

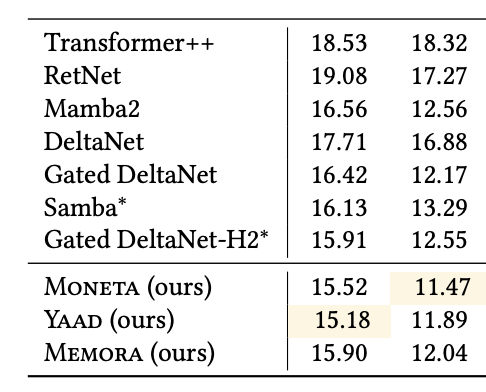

AI가 언어를 얼마나 정교하게 이해하는지 보여주는 지표인 Perplexity는 낮을수록 우수하다는 의미인데요. 여기서도 Titans 기반 모델인 YAAD는 모델은 우위를 보였습니다. 13억 파라미터(1.3B) 모델 기준 비교 결과를 볼까요?

퍼플렉시티 성능 비교. 출처: 구글.

Transformer++는 18.53, 기존 표준 모델인 Mamba2는 16.56을 기록할 때 연구진의 YAAD는 15.18을 기록했습니다. 수치상, YAAD가 훨씬 적은 메모리 용량을 사용하면서도 Transformer++보다 더 똑똑하게 언어를 이해했다는 것을 의미하지요.

예전에 한 셰프는 말단에서 차석 셰프 자리까지 올라간 비결을 묻자, '내게 의존하게 만들었다'고 말합니다. 귀찮고 작은 업무부터 점점 중요한 일까지 자신에게 의존하게 만들어, 결국 원래 있던 수(sous)셰프 자리를 꿰찼다고 밝히지요.

AI는 정보를 단순히 저장하는 단계를 넘어, 실시간으로 공부하고 요약해 기억력까지 향상되고 있습니다. 정작 인간은 요즘 AI에 생각을 의존하면서 기억력이 떨어지는 현상을 보이고 있는데요. 편하다고 마냥 의존하다가 자리가 바뀌는 일은 없기를 바랍니다.