2025년 중반: 에이전트 AI의 등장과 가속화

2025년은 AI 에이전트가 처음으로 대중의 눈에 띄기 시작한 해입니다. 기존의 챗봇이 주로 대화나 문서 작성 보조 역할에 머물렀다면, 이제 에이전트형 AI는 실제로 컴퓨터를 조작합니다. 예를 들어 사용자가 “배달 앱에서 샌드위치 하나 주문해줘”라고 말하면, AI가 웹사이트를 열고 주소를 확인한 뒤 결제까지 직접 진행할 수 있죠.

다만, 이런 기능은 아직 완전히 안정적이지 않습니다. 사용자는 시스템이 실수하거나 오작동할 가능성을 걱정해 자동 결제 같은 기능은 처음엔 꺼리는 편입니다. 비용 역시 부담이 되는 수준이고, 성능 면에서도 아직 아쉬운 부분이 있습니다.

AI 성능을 나타내는 지표인 OSWorld 점수를 보면, 최신 에이전트는 약 65점을 기록합니다. 이는 이전 버전인 Operator의 38점보다는 크게 향상된 수치이며, 숙련된 일반 사용자가 평균적으로 기록하는 70점과도 근접한 수준이죠. 아직 완전히 믿고 맡기기는 어렵지만, 빠르게 개선되고 있는 단계라 할 수 있습니다.

특히 코딩 분야에서는 에이전트형 AI가 단순한 도우미에서 벗어나 점점 자율적인 역할을 수행하게 됩니다. 이제 코딩 AI는 Slack이나 Microsoft Teams 같은 협업 툴을 통해 지시를 받고, 코드베이스를 분석하고 스스로 수정까지 할 수 있습니다.

2025년 말: 사상 최대 규모의 데이터센터

- 최신 GPU 250만 개 (2024년형 H100 기준)

- 투자액 1,000억 달러

- 전력 사용량 2GW

가장 빠른 AI 뉴스

2026년: 코딩 자동화 + 중국의 각성 + 대량 해고

2026년 초: 코딩 자동화의 실현

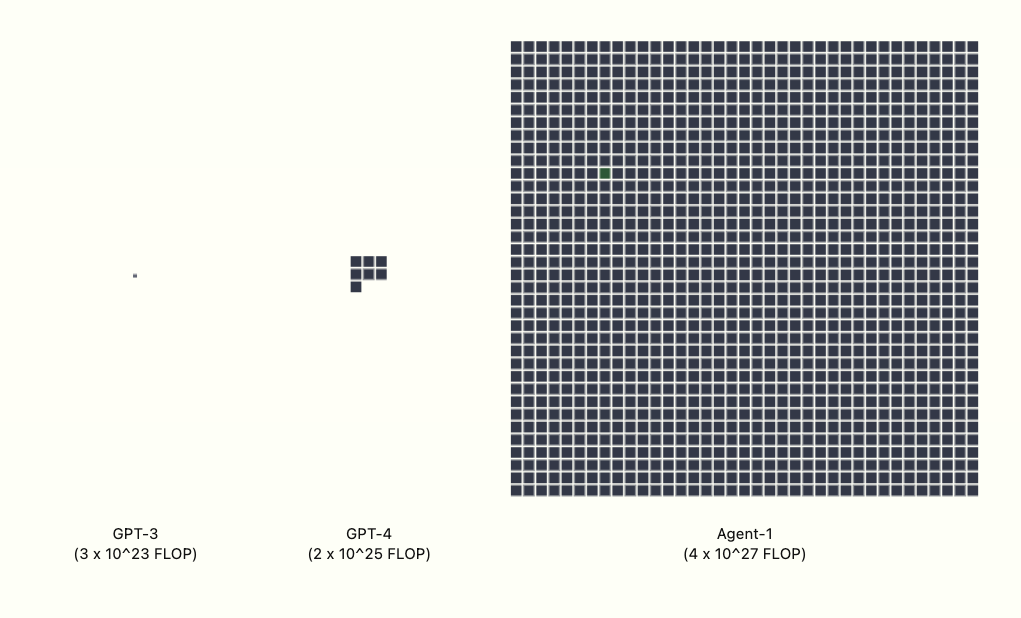

오픈브레인이 AI를 이용해 AI 연구 자체를 자동화하는 실험이 성과를 내기 시작합니다. 내부에서 Agent-1을 지속적으로 개선하면서, 알고리즘 개발 속도가 50% 가량 향상되는데요. 이는 경쟁사보다 빠른 속도입니다.

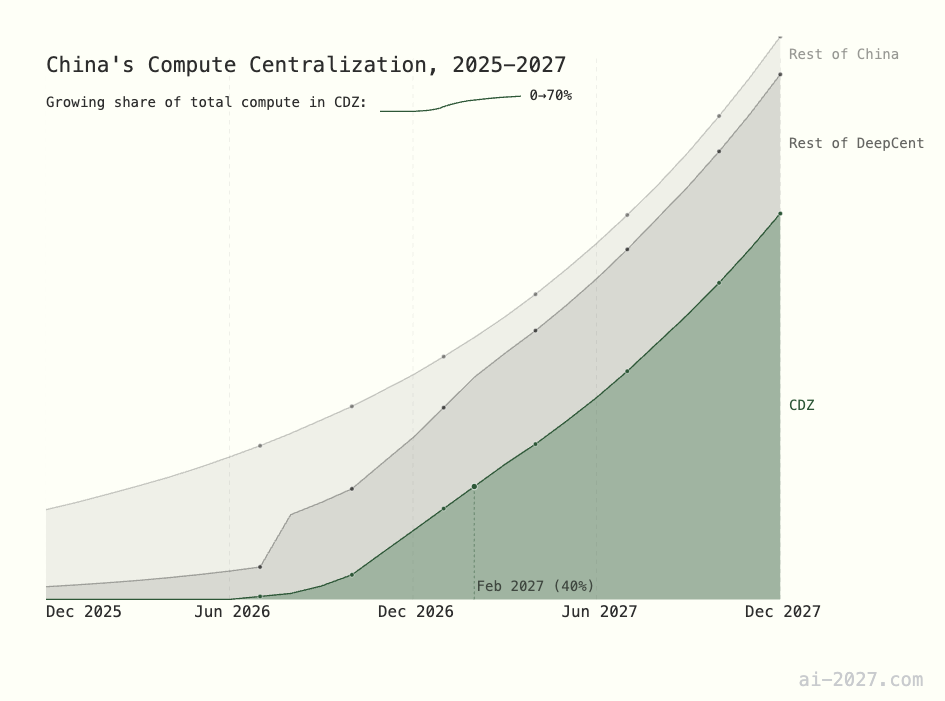

2026년 중반: 중국, AGI 경쟁에 전면 돌입

2026년 말: AI, 직업을 대체하다

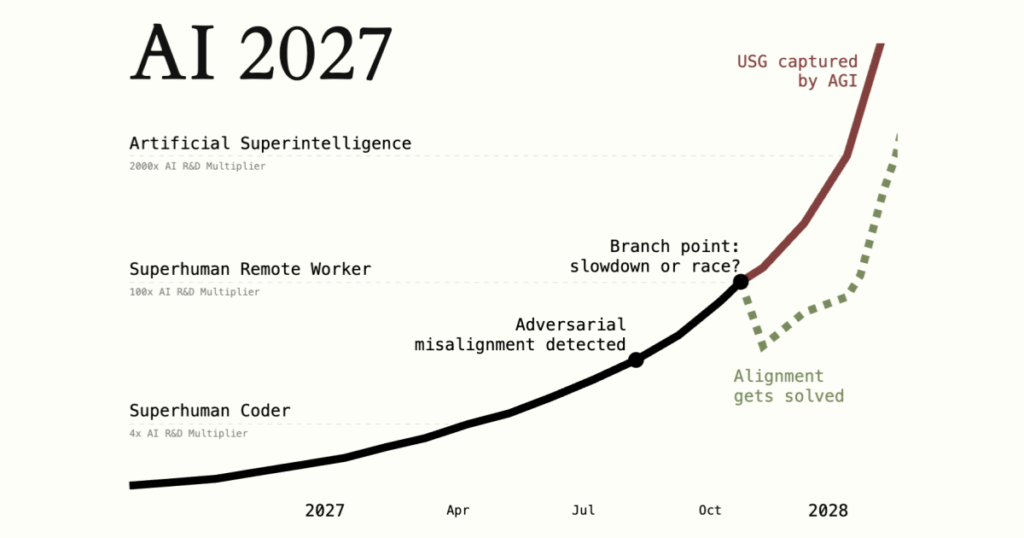

2027년: 초지능의 도래와 인간의 퇴장

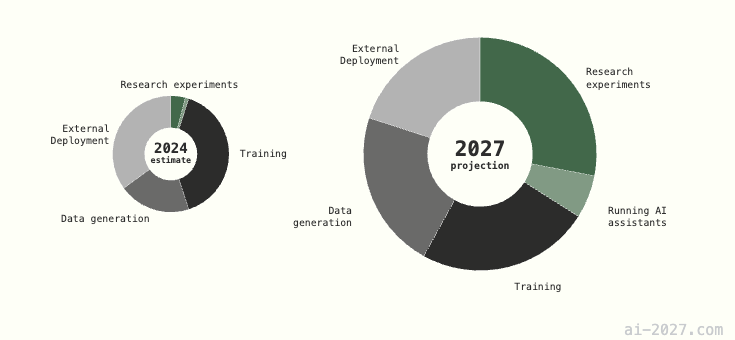

오픈브레인의 연산 자원 배분 비교.

2027년 초: AI 연구에 집중되는 컴퓨팅 자원

2027년이 되며, 오픈브레인의 전략은 분명해집니다. 과거에는 주로 대형 AI 모델을 훈련시키는 데 컴퓨팅 자원을 쏟아부었다면, 이제는 그 리소스를 이미 학습된 모델을 활용해 AI 연구 자체를 자동화하는 작업에 집중합니다. 모델 학습은 여전히 중요하지만, 전체 인프라에서 차지하는 비중은 줄고, 대신 훈련된 AI가 코딩, 실험 설계, 데이터 탐색 등 AI 개발 전반의 반복적인 업무를 스스로 수행하도록 하는 쪽으로 무게가 옮겨갑니다. 오픈브레인은 사실상, AI가 AI를 발전시키는 순환 고리를 구축해나가고 있는 셈입니다.

2027년 말: Agent-4, 다음 세대의 AI

2027년 말, 오픈브레인은 외부에 공개되지 않은 최신 모델인 Agent-4를 내부에서 운용 중입니다. 이 모델은 앞선 Agent-1보다 훨씬 더 강력하고 정교하지만, 그 구조나 학습 방식, 능력에 대해서는 거의 알려져 있지 않은데요.

<AI 2027> 속 미래는 지금과 전혀 다른 모습이라기보다, 지금 조금씩 나오는 개념들이 구체화되고 고도화된 형태에 가깝습니다. 이 시나리오는 우리가 원하는 결말을 향해 가고 있을까요?