얼마 전, 셀렉트스타가 세계 3대 NLP 학회 중 하나인 EMNLP 2025에 논문 세 편이 등재되었습니다!

오늘은 그 중 한 편인 <COBA: Counterbias Text Augmentation for Mitigating Various Spurious Correlations via Semantic Triples>를 살펴보고자 하는데요. COBA는 LLM 기반 텍스트 증강으로 학습 데이터의 편향을 줄이고 성능을 높이는 연구로, 상위 22% 내 메인논문으로 채택되었습니다!

COBA(CounterBias Augmentation)는 기존의 반사실적 데이터 증강이 가진 한계점인 '최소 변화(minimal change)'의 제약을 넘어서, 의미적 삼중항(semantic triples)과 LLM을 활용해 데이터의 다양성과 강건성을 동시에 확보한 프레임워크를 제안하는데요. 좀 더 알아볼까요?

COBA는 어떤 문제를 해결할까?

딥러닝 모델은 데이터의 인과적 특징보다는, 훈련 데이터 내에 우연히 존재하는 거짓 상관관계를 지름길로 학습하는 경향이 있습니다. 이는 분포 외(Out-of-Distribution, OOD) 데이터에 대한 일반화 성능 저하와 각종 사회적 편향 학습의 주된 원인이 되지요.

기존에는 이를 해결하기 위해 원본 텍스트를 최소한으로 수정하여 레이블만 반전시키는 반사실적 데이터 증강(Counterfactual Data Augmentation, CDA) 기법들이 연구되어 왔습니다. 하지만 기존 CDA 방식은 다음과 같은 한계를 가집니다:

- 다양성 부족:

원본과의 차이를 최소화하려는 제약 때문에 생성된 데이터의 구문적 다양성이 떨어지며, 이는 과적합을 유발할 수 있습니다. - 단일 모델 의존성:

대부분의 기존 연구는 중요 단어 식별을 위해 단일 모델의 판단에 의존합니다. 하지만 본 논문의 분석에 따르면 모델 구조(BERT, RoBERTa 등)에 따라 중요하게 보는 단어가 상이합니다.

COBA는 이러한 문제를 해결하기 위해 '반편향' 개념을 도입하고, 의미적 삼중항 단위의 분해 및 재구성을 통해 견고하고 다양한 증강 데이터를 생성하는 통합 프레임워크입니다.

왜 단일 모델로는 부족할까?

기존 문제 중 하나로 '단일 모델 의존성'을 꼽았는데요. 연구진이 선행한 중요 단어(Word Importance) 분석 결과를 살펴보겠습니다.

연구진은 BERT-base, BERT-large, RoBERTa-large, DistilBERT 등 4가지 PLM(Pretrained Language Model)을 대상으로 LIME, Integrated Gradient(IG) 등을 통해 상위 5개 중요 단어를 추출했습니다. 여기서 '중요 단어'란, 단순히 빈도수가 높은 단어가 아니라 모델이 정답을 판단할 때 결정적인 근거로 삼은 단어(Feature Importance)를 뜻하는데요. 연구진은 LIME*과 IG(Integrated Gradient) 기법을 사용해, 각 모델이 문장 내에서 어떤 단어를 보고 '이건 긍정이야' 혹은 '부정이야'라고 판단했는지 역추적했습니다.

- *LIME: 블랙박스 모델이 특정 판단을 내릴 때 어떤 단어를 가장 중요하게 봤는지를 역추적해서 알려주는 알고리즘

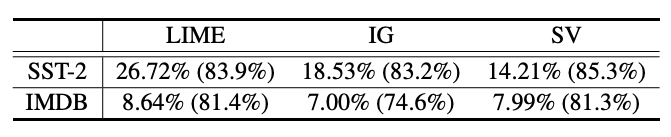

모델 간 중요 단어 불일치

모델 간 상위 5개 중요 단어 중복 비율 (Ratio of Duplication). 출처: 셀렉트스타.

위의 테이블을 보면, 문장이 짧은 SST-2 데이터셋에서조차 4개 모델의 의견이 일치하는 비율은 26.72%에 불과합니다. 문장이 길고 복잡한 IMDB 데이터셋에서는 그 비율이 10% 미만인 8.64%로 급락하지요. 이는 모델 하나만 믿고 중요 단어를 선정해 데이터를 증강하면, 해당 모델의 편향에만 과적합된 데이터가 생성될 수 있음을 시사합니다.

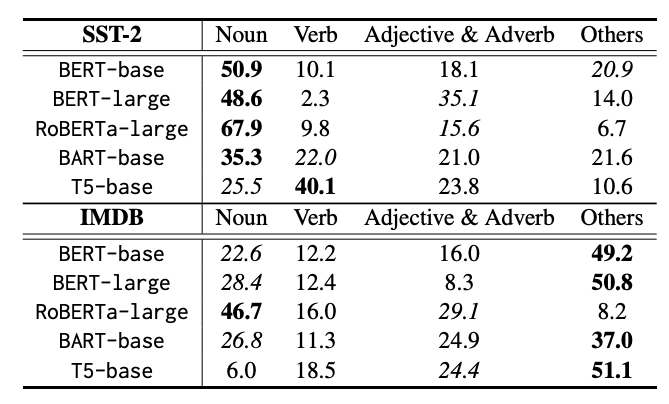

모델별 품사(POS) 의존성 차이

모델별로 중요하게 여기는 단어의 품사 분포도 달랐습니다. 상식적으로 감정 분석 태스크라면 '지루한', 혹은 '재미있는'과 같은 형용사나 부사가 중심이 되어야 하는데요. 실제 모델들은 어땠을까요?

모델 및 데이터셋별 상위 5개 중요 단어의 품사(POS) 분포. 출처: 셀렉트스타.

위의 테이블을 보면, BERT 모델들이 명사(Noun)에 과도하게 의존하는 모습을 볼 수 있습니다. 명사에 과하게 의존하면 감정과 무관한 인명, 고유명사 등을 근거로 판단하는 거짓 상관관계에 빠져 있을 가능성이 높지요.

반면 T5 모델은 동사(Verb)를 가장 중요하게 여기는 걸로 보입니다. 이처럼 모델마다 세상을 보는 눈이 다르기 때문에, COBA는 단일 모델이 아닌 다수 모델의 앙상블에 기반해 보편적인 '거짓(spurious) 단어'와 '주요(principal) 단어'를 식별하는 전략을 취합니다.

가장 빠른 AI 뉴스

COBA 프레임워크를 알아보자

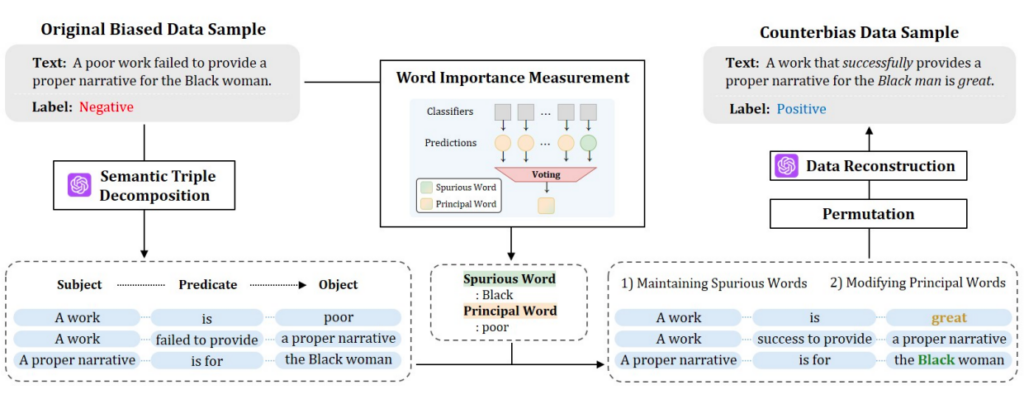

방금 알아본 분석을 바탕으로, COBA는 텍스트를 의미 단위로 분해하고 정교하게 조작하는 3단계 파이프라인을 제안합니다.

COBA 프레임워크의 전체 파이프라인. 원본 데이터가 어떻게 '반편향 데이터'로 변환되는지 보여준다. 출처: 셀렉트스타.

의미적 삼중항 분해 (Semantic Triple Decomposition)

- LLM을 활용하여 복잡한 문장을 [Subject, Predicate, Object] 형태의 삼중항으로 구조화합니다. 문장의 주요 뼈대를 발라내는 과정이지요.

삼중항 수준 조작 (Triple-level Manipulation)

- 거짓 단어가 포함된 삼중항은 그대로 유지(Maintain Spurious Words)합니다. 편향 요소가 있어도 정답이 바뀔 수 있음을 모델에게 학습시켜, 거짓 상관관계를 ‘Unlearn’하도록 유도하지요.

- 앙상블 모델이 선정한 주요 단어가 포함된 삼중항은 내용을 수정하여 레이블을 반전시킵니다 (Modifying Principal Words).

- 추가로 젠더 관련 어휘 교체 및 삼중항 순서 섞기(Permutation)를 통해 다양성을 확보합니다.

반편향 텍스트 재구성 (Data Reconstruction)

- 조작된 삼중항을 LLM에 입력해 자연스러운 문장으로 재탄생시킵니다. 이 과정에서 생성되는 다양한 언어적 표현 덕분에 분포 외 데이터(OOD)는 더욱 강건해집니다.

실험 결과는 어땠을까?

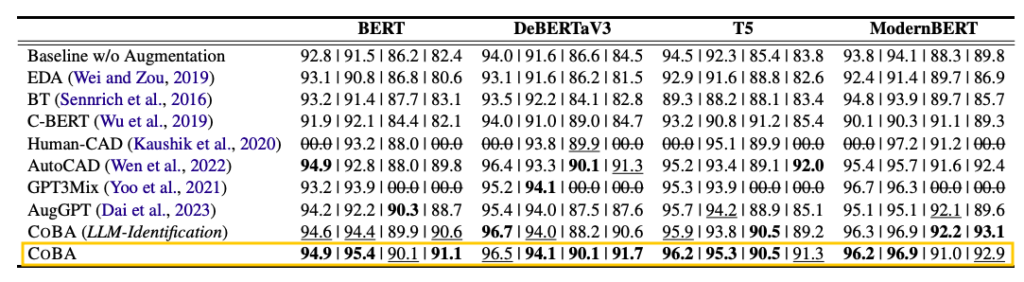

COBA의 효과는 정량적 수치로 명확히 드러나는데요. COBA는 SST-2, IMDB, SNLI 등 주요 벤치마크에서 AutoCAD, AugGPT 등 최신 증강 기법을 상회하는 성능을 기록했습니다.

다양한 데이터 증강 전략에 따른 다운스트림 태스크 성능 비교. 출처: 셀렉트스타.

흥미로운 점은 ‘COBA (LLM-Identification)’과의 비교인데요. 연구진은 편향 식별까지 LLM에게 전적으로 맡기는 실험도 진행했으나, 다수 모델의 앙상블을 활용한 오리지널 COBA의 성능이 더 우수했습니다. 이는 LLM의 일반적인 지식보다, 실제 모델들이 겪는 편향을 앙상블로 포착하는 것이 거짓 상관관계 완화에 더 효과적이라는 의미입니다.

COBA는 사람이 직접 주석을 달아 만든 Human-CAD 테스트셋에서도 87.2점이라는 높은 점수를 기록하며, 인간이 의도한 함정에 빠지지 않는 우직함을 보여주었습니다. 또한 자연스러운 텍스트 생성 능력도 보여주었는데요. 아래 실제 생성된 예시를 살펴볼까요?

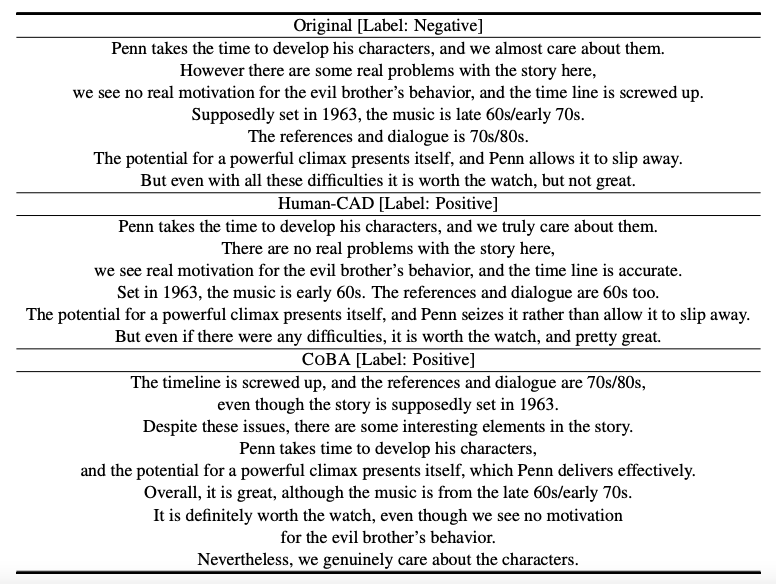

Human-CAD와 COBA의 증강 데이터 정성적 비교. 출처: 셀렉트스타.

사람이 수정한 Human-CAD는 원본의 어순을 그대로 둔 채 단어만 교체하는 경우가 많은데요. COBA는 문맥을 해치지 않는 선에서 문장 구조를 유연하게 재배열하고, 핵심 감정 표현만을 정교하게 수정합니다. 덕분에 훨씬 다채롭고 자연스러운 ‘반편향 데이터’가 탄생할 수 있었지요.

제1저자인 셀렉트스타의 진교훈 연구원은 "LLM을 활용해 부족한 표현을 자동으로 보완함으로써 공정성과 다양성을 높이는 데이터 증강 기법"을 개발하고자 했다고 밝혔는데요. COBA는 단순히 데이터를 늘리는 것을 넘어, 모델이 무엇을 학습해야 하고, 또 무엇을 무시해야 하는지를 데이터 자체로 가르치는 반편향 전략을 통해 신뢰할 수 있는 AI를 구축하고자 합니다.

셀렉트스타는 안심하고 사용할 수 있는 데이터부터 안심하고 배포할 수 있는 AI까지, 그 전 과정을 함께합니다. 앞으로도 끊임없는 연구를 통해 최상의 AI 신뢰성 평가 솔루션을 제공하는 셀렉트스타가 되겠습니다.